Introducción

Vivimos en un mundo tecnológico. Nuestro trabajo, entretenimiento, salud, transporte, educación, economía y comunicación dependen y se ven enriquecidos por la tecnología. Sin embargo, somos muy pocos --y aún menos mujeres-- quienes creamos tecnología y la utilizamos como herramienta para resolver problemas.

Durante más de 25 años he investigado en cómo modelar el comportamiento humano usando técnicas de Inteligencia Artificial (IA). He trabajado con habitaciones, ropas, coches y móviles inteligentes. He inventado sistemas capaces de reconocer comportamientos o características humanas, como expresiones faciales [1], actividades [2], interacciones [3], maniobras de la conducción [4], la apnea del sueño [5], el riesgo crediticio [6], los puntos calientes de crimen en las ciudades [7] o incluso el aburrimiento [8]. He construido sistemas interactivos e inteligentes en ordenadores y teléfonos móviles [9] [10]. He sentido en primera persona la felicidad profunda que te invade cuando lo que no era más que una idea --a veces incluso un tanto alocada-- se convierte en una realidad que puede ayudar a millones de personas.

He sido arte y parte, testigo y partícipe, del progreso tecnológico, de la presencia cada vez más relevante y ubicua de la tecnología en nuestras vidas, de la dependencia que hemos desarrollado hacia ella.

La inspiración y el motor de mi trabajo han sido, durante toda mi carrera, preguntas con una clara aplicación social. La persona, en sentido individual y colectivo, ha sido y es el elemento central en todos mis proyectos: tecnología dotada de inteligencia por y para la sociedad, tecnología capaz de entendernos como paso previo a ayudarnos. Sin embargo, el impacto que esa misma tecnología está teniendo ahora, ya, en nuestras vidas no siempre es positivo, y por eso siento preocupación. Me pregunto si no nos encontramos ante una crisis social de base tecnológica.

Al mismo tiempo, no tiene sentido aspirar a frenar el desarrollo tecnológico: explorar lo desconocido y empujar el estado del arte forma parte de la esencia del ser humano. Además, necesitamos la tecnología para sobrevivir como especie, superando retos tan inmensos como el cambio climático, la sostenibilidad del planeta, el envejecimiento de la población y la prevalencia cada vez mayor de las enfermedades crónicas.

La Inteligencia Artificial (IA) está abandonando velozmente la esfera de la ciencia ficción. Los sistemas enriquecidos con IA forman hoy parte de nuestra vida cotidiana, y tendrán un papel mucho más relevante en el futuro. El potencial de la IA para transformar a fondo la sociedad, en prácticamente todos los ámbitos, es inmenso. Pero corremos el riesgo de que un porcentaje muy elevado de la ciudadanía quede al margen de esta transformación. Es más, la metamorfosis no será necesariamente positiva para el conjunto de la sociedad si no trabajamos activamente para que así sea, exigiendo que los avances contribuyan de verdad al progreso, a la igualdad, a la prosperidad... A un mundo mejor para todos, no solo para unos pocos.

Por ello este primer libro de la colección Pensamiento para la Sociedad Digital está centrado en la Inteligencia Artificial, haciendo un breve recorrido por su historia, describiendo su impacto actual y planteando los retos que presenta desde diferentes perspectivas. Las últimas páginas esbozan mi visión del futuro. Una visión que no puede ser sino esperanzadora.

Amor a primera vista

Por qué investigo en tecnología basada en el comportamiento humano

Entendí realmente el poder de la Inteligencia Artificial con mi proyecto de fin de carrera. Había escrito un programa para detectar automáticamente coches en vídeos de autopistas, mi primer programa para que un ordenador hiciese algo "inteligente"; de pronto vi, con sorpresa, que conseguía no solo detectar los coches, sino además seguirlos. ¡Qué sensación de empoderamiento! Me di cuenta del valor de la tecnología para ayudarnos a abordar problemas complejos, a hacer tareas de manera más eficiente. Me inspiré para seguir creando tecnología que nos entienda y nos ayude aún más. Por eso he dedicado mi vida profesional a la investigación en Inteligencia Artificial, o IA, y más concretamente al modelado computacional del comportamiento humano.

Soy ingeniera de telecomunicaciones. He aprendido y trabajado en lugares donde se forjaba la era digital que hoy envuelve nuestras vidas, y en los principales focos de creación de las tecnologías inteligentes. Ahora investigo desde Alicante, donde nací y vivo con mi familia. Trabajo para varias compañías y organizaciones. Soy Chief Data Scientist --algo así como investigadora principal de datos-- en Data-Pop Alliance, una ONG dedicada al Big Data y la IA para el bien social; y Chief Scientific Advisor en el Vodafone Institute, un laboratorio de ideas basado en Berlín. También colaboro con numerosas instituciones, incluyendo ELLIS, que busca fomentar la investigación excelente en Inteligencia Artificial en Europa; y OdiseIA, que aspira a contribuir a un uso ético de la Inteligencia Artificial. He sido hasta hace poco la primera directora de Investigación en Ciencias de Datos a nivel mundial de Vodafone.

Mi próximo reto es crear desde cero una unidad ELLIS en Alicante, dedicada a la investigación excelente en Inteligencia Artificial, y conectada con una veintena de otras unidades ELLIS en diferentes países europeos. Una red de excelencia para conseguir atraer, retener e invitar a la próxima generación de talento excelente en investigación en Inteligencia Artificial a quedarse en Europa.

Durante un fascinante período en mi etapa formativa realmente sentí que estábamos inventando el futuro: realidad aumentada, ropa inteligente, coches inteligentes, informática afectiva, tinta electrónica, objetos conectados... Estas aplicaciones hoy convertidas en realidad --o a punto de serlo-- fueron algunas de mis áreas de investigación en los años noventa.

Por supuesto, no crecí pensando que me dedicaría a esto. Mi primer contacto con las telecomunicaciones fue durante la Semana Santa de mi último año de bachillerato. Sentía la presión de tener que elegir una carrera, y no sabía cuál. Siempre me ha apasionado la ciencia; Leonardo da Vinci, Marie Curie, Albert Einstein... me atraía enormemente la figura del inventor/investigador. Desgraciadamente no podía preguntar a esos gigantes del conocimiento en qué consistía su trabajo, ni cómo llegaron a él. Pero un amigo de mi hermano, Miguel Vallés, que hacía "Teleco" en Madrid y había venido a Alicante a pasar la Semana Santa, me habló con tanta pasión de las telecomunicaciones, de sus aplicaciones prácticas y de la vida en un colegio mayor, que me contagió. Decidí estudiar Ingeniería de Telecomunicación en la Universidad Politécnica de Madrid (UPM).

Fue el primer paso hacia la realización de muchos de mis sueños. Siempre estaré agradecida a Miguel por contarme su experiencia, por inspirarme, por ayudarme --sobre todo en el aterrizaje en Madrid-- y por su amistad generosa e inquebrantable todos estos años.

Entendí pronto, incluso antes de saber a qué área específica me dedicaría, el grandísimo potencial de la tecnología para mejorar la sociedad. Mi pasión era y sigue siendo la investigación, así que mi idea fue hacerme investigadora en algún tema tecnológico. Así fue como, siendo estudiante, descubrí la Inteligencia Artificial. Fue amor a primera vista.

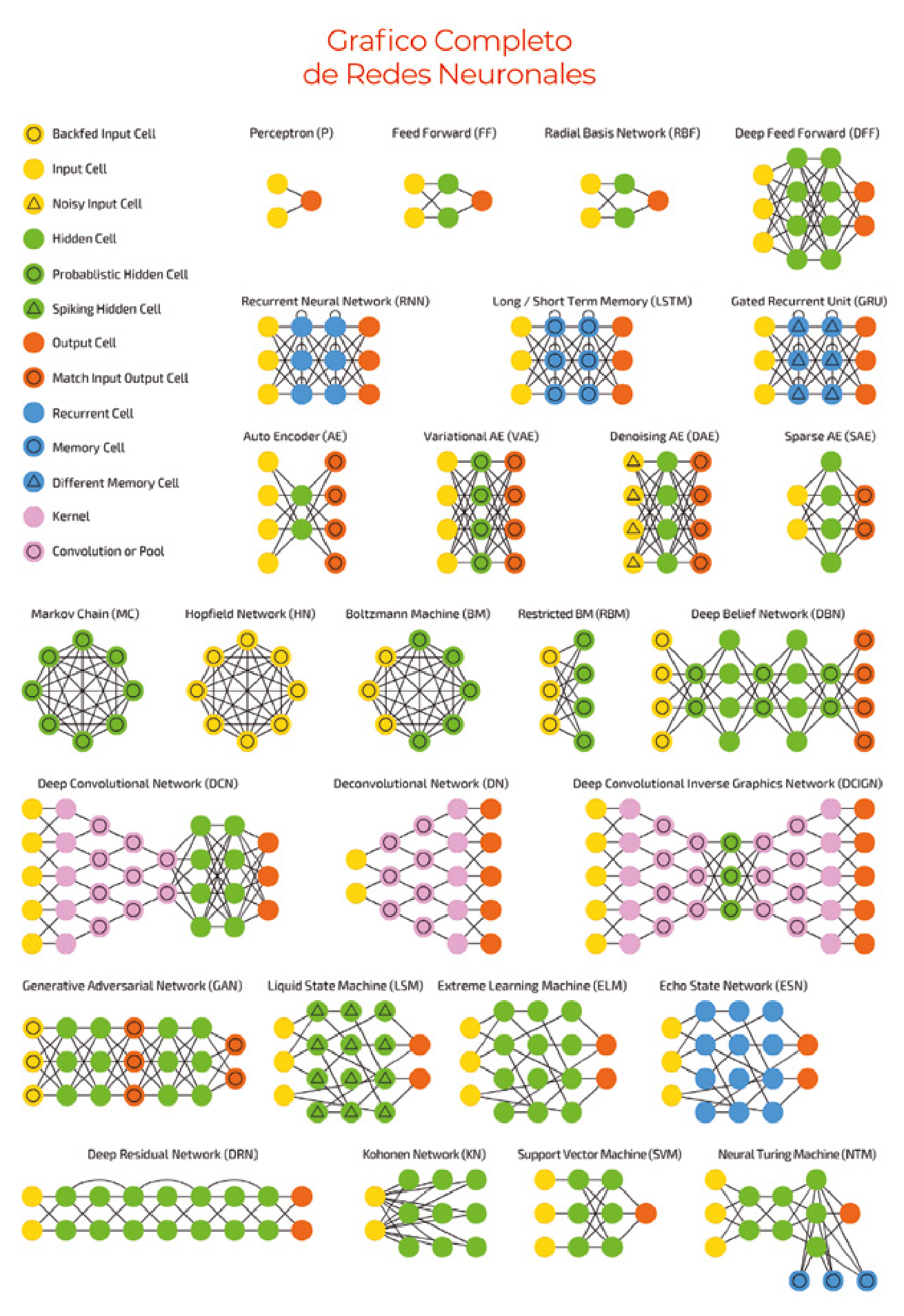

La imaginación es el límite

Mi primera publicación científica la presenté siendo estudiante de tercero o cuarto de carrera --no recuerdo bien--, en un congreso en Roma, tutelada por mi gran profesora, hoy amiga, Carmen Sánchez. Era un trabajo sobre redes neuronales, uno de los primeros modelos de Inteligencia Artificial inspirado en la manera en que aprende el cerebro humano. Poco después hice el proyecto fin de carrera, tan decisivo para mí, dentro del Grupo de Tratamiento de Imágenes de la UPM, liderado por el profesor Narciso García. Ese trabajo para identificar automáticamente coches en vídeos, con técnicas de visión por ordenador, dio fuerza y forma a mi primer gran sueño: estudiar un doctorado en Inteligencia Artificial en Estados Unidos.

Pude hacerlo realidad gracias a una beca de la Fundación Obra Social la Caixa, y a que me aceptaron en siete universidades estadounidenses --todas a las que apliqué-- incluyendo Stanford, Caltech, Carnegie Mellon y el Instituto Tecnológico de Massachusetts (MIT). Me sentía muy afortunada. Tras un proceso de decisión obligatoriamente difícil opté por el legendario Media Lab del MIT. Comencé así mi carrera científica bajo la dirección del profesor Sandy Pentland, uno de los investigadores en ciencias de la computación más citados del mundo, de quien sigo aprendiendo y a quien tan agradecida estoy.

He de reconocer que el MIT impone. Yo aterricé con cierto temor a carecer de la formación necesaria para sobrevivir en un entorno académico tan exigente, pero resultó que la educación recibida en la Escuela de Telecomunicación de la UPM era, en muchas áreas, incluso más completa y profunda --aunque menos experimental-- que la de mis compañeros en el MIT. Me sentí como pez en el agua.

Fueron años de trabajo intenso, pero muy divertido y enriquecedor. Prácticamente vivía en el laboratorio, trabajando todos los días --fines de semana incluidos-- con gran dedicación y pasión. Compartimos experiencias inolvidables: las demos --el lema del Media Lab es demo or die--, los eventos con los patrocinadores, el primer desfile del mundo de ropa inteligente, las carreras de coches de fórmula Dodge...

Fue un periodo de aprendizaje constante, de gran creatividad y estimulación intelectual, y de exposición a una cultura extremadamente positiva que ya forma parte de mi identidad. Una cultura que fomenta el asumir riesgos, que considera las equivocaciones un regalo de la vida para aprender y donde no hay más límite que tu propia imaginación. Conservo de entonces amistades intensas con personas extraordinarias, autoras de profundas contribuciones a la ciencia y a la sociedad. También fueron años duros de trabajo sin descanso, a miles de kilómetros de mi familia y con un clima inhóspito en invierno y en verano.

Estuve en el Media Lab desde finales de agosto de 1995 hasta junio del año 2000, una etapa dorada para este laboratorio justo antes de la crisis de las puntocom. Hice el doctorado en poco tiempo, teniendo en cuenta la duración media entonces de los doctorados en el Media Lab. Fue una época de gran optimismo respecto a la tecnología, un periodo de creatividad y de definición de algunas de las áreas tecnológicas que son hoy día una realidad.

Por ejemplo, mi primer proyecto en el MIT fue LAFTER [1:1], uno de los primeros sistemas en el mundo de reconocimiento de expresiones faciales en tiempo real. Ahora lo hacemos con un móvil, pero en 1995 reconocer expresiones era casi ciencia ficción. También, en 1997 organizamos el primer desfile de ropa inteligente del mundo, y trabajé en un coche capaz de detectar y además predecir las maniobras de los conductores. Otro de mis proyectos, para museos, reconocía en tiempo real los cuadros y mostraba en unas gafas de realidad aumentada --término que apenas había salido de los laboratorios-- un vídeo explicativo sobre ellos, de nuevo una aplicación que ahora no sorprende pero que hace dos décadas era experimental.

Dejé el MIT para iniciar mi carrera profesional en los laboratorios de investigación de Microsoft, investigando con Eric Horvitz y Mary Czerwinski. Durante este periodo me di cuenta de que si mi sueño --¡otro!-- era conseguir que los ordenadores nos entendieran --como paso necesario previo a ayudarnos--, debía enfocar mi trabajo al que es el ordenador más personal: el móvil. Por ello desde 2005 he investigado casi exclusivamente en proyectos relacionados con móviles, acercándome de nuevo a las telecomunicaciones.

Un perfil poco común

Nunca pensé que podría regresar a España, aunque siempre lo deseé.

Durante mucho tiempo la vuelta fue solo un sueño más. Pero hace trece años Telefónica me ofreció la oportunidad de regresar como Directora Científica --la primera mujer-- en Telefónica I+D, en Barcelona, y fue como si la diosa Fortuna de nuevo llamara a mi puerta.

El reto profesional era grande: definir la visión de un área de investigación nueva para la compañía; identificar, atraer y liderar talento; publicar y patentar. También, aprender a ser directora y a desarrollar mi capacidad de liderazgo, en femenino. En el plano personal debíamos comenzar de cero en una ciudad donde no conocíamos a nadie. Un nuevo capítulo en nuestras vidas. Un gran desafío y, a la vez, una oportunidad maravillosa de contribuir al progreso científico en España.

En efecto la vuelta fue intensa desde todos los puntos de vista. Gracias a la red de becarios de La Caixa, y también a través del colegio de mis hijos, conocimos a grandes personas que son hoy amigos y amigas. Pronto nos sentimos integrados. En cuanto al plano profesional, mi papel fue ser agente de cambio.

Hoy en día los datos --lo que llamamos Big Data-- y la Inteligencia Artificial son elementos estratégicos para la mayoría de las empresas de telecomunicaciones, pero no era así hace más de una década. Mi objetivo era crear y liderar en Telefónica I+D las áreas en que se centra mi investigación: la Inteligencia Artificial, el análisis de Big Data, la personalización, la interacción persona-móvil. Eran áreas emergentes para una compañía tradicionalmente enfocada, como todas las compañías de telecomunicaciones, en redes y sistemas de comunicación.

Me siento muy orgullosa del trabajo realizado durante casi nueve años en Telefónica I+D. Obtuvimos numerosos premios y nominaciones a mejor artículo científico; decenas de patentes; y proyectos de investigación que dieron lugar a nuevos productos e incluso a compañías. También contribuimos a la creación del área de Big Data e Inteligencia Artificial a escala global y creamos el área de Big Data para el Bien Social, entre otros logros.

Sé que mi perfil como investigadora y directora de investigación, con impacto a nivel científico y en la sociedad, es poco común en España. Aquí puede costar entender que tenga una carrera científica de primer nivel sin estar en una universidad, o en un organismo público de investigación. Eso ocurre porque la investigación industrial en inteligencia artificial en EE. UU. y España es diferente. EE.UU. cuenta con potentísimos laboratorios de investigación en Inteligencia Artificial en las empresas tecnológicas --Microsoft, Facebook, Google, Apple, Amazon, IBM--, mientras que en España no hay tradición de que se investigue en este campo, fundamentalmente porque no hay grandes tecnológicas españolas. Defiendo que es importante que haya investigación tanto en el sector público como en el privado, y en colaboración. Muchos de mis proyectos de investigación han sido en colaboración con universidades.

Trabajo global, vida local

Dicen que la vida es cíclica, y sin duda en mi caso así ha sido. Hace cuatro años decidimos mudarnos a Alicante para estar junto a mi familia. Gracias a las telecomunicaciones hemos podido convertir en realidad lo que parecía imposible. Tanto mi marido --arquitecto de software de Microsoft-- como yo trabajamos desde casa: la tecnología nos ha permitido encontrar un equilibrio entre una vida profesional intensa y global, y una vida personal no menos intensa, pero más local. Hay intangibles sumamente valiosos en la vida, como crecer cerca de tus abuelos, tíos, primos... Mi marido, que es de origen alemán, y yo nos sentimos afortunados de poder ofrecer esa experiencia vital a nuestros hijos.

Estando en Alicante decidí dejar Telefónica para embarcarme en tres nuevas aventuras: Data-Pop Alliance, Vodafone y el Vodafone Institute. Aunque recientemente he dejado Vodafone, sigo investigando a través de Vodafone Institute y de Data-Pop Alliance, donde abordamos cómo el Big Data puede ayudarnos en áreas relativas a los Objetivos de Desarrollo Sostenible, como la salud pública, la seguridad física, la igualdad de género, la inclusión financiera o la educación.

También intento tener impacto en mi región, dando charlas en las universidades, al público en general y, en especial a adolescentes, para inspirarles y acercarles --sobre todo a las chicas-- hacia las carreras tecnológicas. Además, a través de la nueva unidad ELLIS que espero poder crear en breve, tengo la oportunidad de atraer talento investigador excelente a la Comunidad Valenciana, conectado con una comunidad de investigadores en otros países de Europa.

La divulgación científico-tecnológica me parece esencial, así que dedico parte de mi tiempo a colaborar con medios de comunicación y a apoyar eventos científico-tecnológicos para todos los públicos. Asesoro a varias universidades, a la compañía Mahindra Comviva, a la Fundación Gadea Ciencia, a la Comisión Europea, al Foro Económico Mundial y a los Gobiernos valenciano y español, sobre tecnología y especialmente IA y Big Data.

Con la perspectiva de más de dos décadas desde que descubrí la Inteligencia Artificial en la UPM, siento hoy un gran entusiasmo por ver convertidas en realidad muchas de las ideas a las que contribuí hace un cuarto de siglo. Me apasiona poder ayudar con mi trabajo a mejorar la calidad de vida de las personas y de nuestro planeta gracias a la IA.

No obstante, a pesar del impacto positivo de la IA en nuestra sociedad, también siento preocupación. El desarrollo de la Inteligencia Artificial por y para la sociedad requiere no solo una inversión ambiciosa en la investigación, innovación y adopción de la IA en el tejido empresarial, sino también la definición y cumplimiento de marcos éticos y regulatorios apropiados. Es además imprescindible una profunda reforma educativa a todos los niveles, combatiendo activamente la falta de equilibrio, de diversidad geográfica, demográfica e institucional en la expansión de una tecnología capaz de transformar profundamente nuestra forma de vida. De mi pasión por la IA, y de mi sueño de usarla para el beneficio de todos, nace este libro.

TECNOLOGÍA PARA LAS PERSONAS (Y NO AL REVÉS)

Mi investigación ha contribuido a aumentar la presencia de la IA en nuestras vidas. He impulsado el reconocimiento automático en imágenes de vídeo de expresiones faciales [1:2] y de interacciones humanas [3:1], dos habilidades necesarias para que los ordenadores entiendan nuestro estado emocional, y para automatizar tareas de vigilancia, entre otras aplicaciones. También he trabajado en la identificación automática de las actividades que se llevan a cabo en una oficina [2:1], para mejorar el diseño de espacios de trabajo inteligentes-; en la predicción de las maniobras de la conducción [4:1], -para aumentar nuestra seguridad al volante-, y en el modelado automático de características humanas como la personalidad, para desarrollar tecnología que nos comprenda y pueda, en consecuencia, ayudarnos.

Uno de mis objetivos ha sido diseñar tecnología que se adapta a nosotros, y no al revés. He propuesto modelos de recomendación --de compras, ocio, amigos-- que incorporan información de contexto, como el día de la semana o la localización, porque nuestras necesidades varían en función del momento y el lugar [11]. He diseñado algoritmos para optimizar la selección de resultados [12], y para que las recomendaciones incluyan opiniones de expertos.

Así ha surgido el concepto de la sabiduría de los expertos, que complementa a la sabiduría de las masas [13]--basada en acciones y opiniones de personas similares a ti--, y uno de los fundamentos de los algoritmos de recomendación.

En varios proyectos he buscado convertir el móvil en un asistente para la salud y el bienestar. HealthGear [5:1] detecta automáticamente la apnea del sueño; MoviPill [9:1] ha mejorado la adherencia al tratamiento de los enfermos crónicos en un 60%, al convertir en un juego social la toma correcta de la medicación.

En el ámbito financiero la unión del móvil y la IA puede igualmente ser fuente de mejoras. Unos 1.700 millones de personas en el mundo no tienen cuenta bancaria pero sí acceso a un móvil, lo que convierte a esta herramienta en una de las llaves para lograr la inclusión financiera, es decir, el acceso de todos a productos y servicios financieros de calidad. En MobiScore [6:1] diseñamos un sistema para la inferencia de riesgo crediticio en economías en desarrollo a partir de patrones de uso del móvil, y permitir así el acceso a crédito a al menos una parte de quienes carecen de cuenta corriente. Al mismo tiempo hemos investigado los factores que llevan a la adopción del dinero móvil en África, un fenómeno que fomenta la inclusión financiera, ya que permite realizar transacciones a personas sin cuenta bancaria, pero con móvil (no necesariamente un smartphone) [14].

En Telefónica y en Vodafone creé un área de investigación para analizar grandes cantidades de datos agregados y (pseudo)anonimizados con fines sociales positivos. A esta tarea se dedica Data-Pop Alliance. Aplicar técnicas de IA al estudio de este tipo de datos procedentes de la red de telefonía móvil nos abre muchas puertas. Nos permite desde entender mejor el comportamiento en las ciudades, por ejemplo, para detectar automáticamente puntos calientes de crimen [7:1], hasta estimar el impacto de desastres naturales, como terremotos e inundaciones [15], y modelar la propagación de enfermedades infecciosas como la malaria [16].

La historia de la IA

Un paseo personal por la historia de la IA

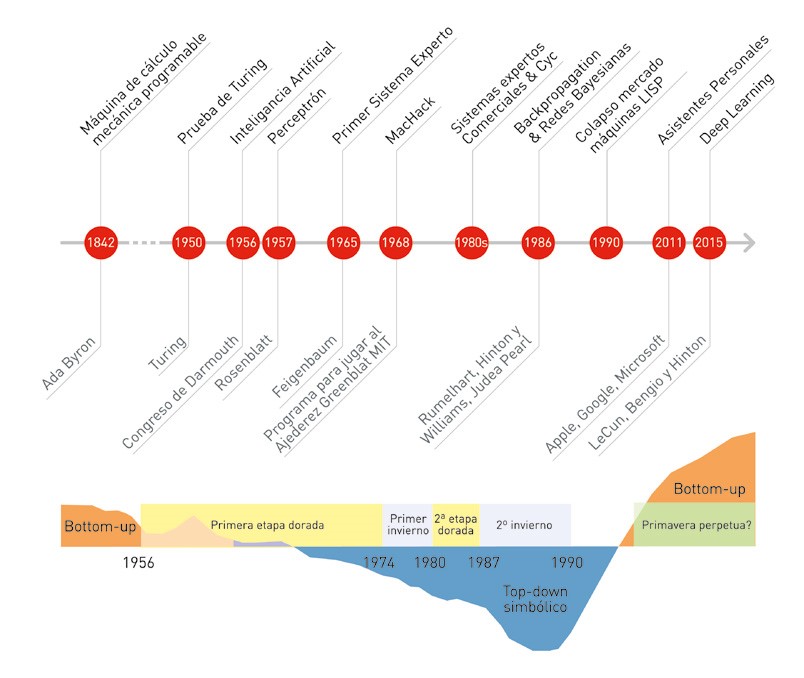

Lo hemos asumido: las máquinas nos superan a nosotros, sus creadores, incluso en tareas asociadas a la capacidad de estrategia y a la intuición. ¿Cómo lo han conseguido? ¿Significa que pueden pensar como nosotros? A todo esto, ¿cómo pensamos nosotros? El esfuerzo por crear cerebros no biológicos parte de la reflexión sobre el pensamiento y el aprendizaje humanos, e incluye ambiciosas visiones futuristas; pruebas para detectar inteligencia; y procesadores y algoritmos capaces de analizar, dar sentido y aprender a partir de cantidades ingentes de datos, entre otros elementos. El éxito, en última instancia, curiosamente depende de la capacidad de otorgar a los errores el valor (matemático) que se merecen.

Aunque la Inteligencia Artificial (IA) parezca algo novedoso, el desarrollo de máquinas capaces de pensar o dotadas de algunas capacidades humanas ha cautivado nuestro interés desde la antigüedad. Los primeros autómatas --robots antropomorfos-- que imitaban movimientos humanos fueron construidos hace milenios.

Según la Ilíada, Hefesto --el dios griego del fuego y la forja-- creó dos mujeres artificiales de oro con "sentido en sus entrañas, fuerza y voz" que lo liberaban de parte de su trabajo, es decir, creó robots para que lo ayudaran, lo cual lo convierte en todo un adelantado a su tiempo. Heron de Alejandría en el siglo I escribió Automata, donde describe máquinas capaces de realizar tareas automáticamente, como estatuas que sirven vino o puertas que se abren solas. Otros ejemplos incluyen autómatas con fines religiosos, como las figuras mecánicas de los dioses en el Antiguo Egipto, operadas por sacerdotes para sorprender a la multitud; y también lúdicos: las famosas cabezas parlantes y autómatas de la Edad Media, el Renacimiento y el siglo XVIII.

Más allá de la automatización, el ser humano siempre ha sentido curiosidad por explicar y entender la mente humana para, entre otros motivos, construir una mente artificial. Hace más de 700 años, Ramon Llull --beato y filósofo mallorquín patrón de los informáticos-- describió en su Ars Magna (1315) la creación del Ars Generalis Ultima, un artefacto mecánico capaz de analizar y validar o invalidar teorías utilizando la lógica: un sistema de Inteligencia Artificial.

La creadora, en el siglo XIX, del primer algoritmo destinado a ser procesado por una máquina --en otras palabras, el primer programa informático-- fue la matemática Ada Byron (Lovelace). Su visión de que las máquinas podrían servir para algo más que para hacer cálculos matemáticos convirtió a Byron en la primera persona en proponer el uso de la máquina analítica de Babbage para resolver problemas complejos. La máquina de Babbage, no obstante, con sus previstos treinta metros de largo por diez de ancho, nunca llegó a construirse. Se la considera el primer diseño de un computador de propósito general, pero los obstáculos técnicos y la falta de respaldo político --en parte por miedo a un posible uso bélico-- no permitieron convertirla en realidad.

Una conversación inteligente

El mito y la ficción literaria respecto a la Inteligencia Artificial empezaron a materializarse a partir de los años cuarenta del siglo XX, con los primeros ordenadores.

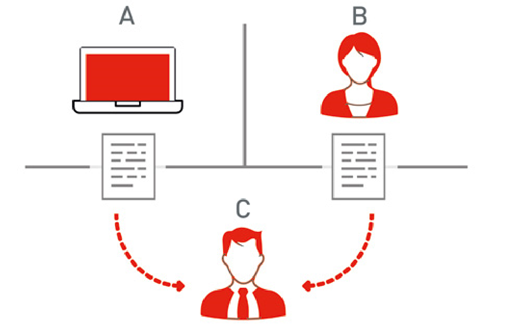

El genial matemático e informático inglés Alan Turing es considerado el padre de la Inteligencia Artificial. Habló de ella en el legendario artículo Computing Machinery and Intelligence, publicado en 1950. Es en este trabajo donde propone la famosa prueba de Turing, ilustrada en la Figura 1, para determinar si un sistema artificial es inteligente.

El ejercicio consiste en que un humano (C en la figura), conocido como el interrogador, interacciona vía texto con un sistema al que puede hacer preguntas. Si el humano no logra discernir cuándo su interlocutor es una máquina (A en la figura), y cuándo otra persona (B en la figura), entonces el sistema supera la prueba de Turing: es inteligente.

La década fundacional para la Inteligencia Artificial fue la de los cincuenta. En 1951 el profesor Marvin Minsky --a quien tuve el honor de conocer en el MIT-- construyó la primera red neuronal computacional como parte de su doctorado en la Universidad de Princeton. Se trataba de una máquina con válvulas, tubos y motores que emulaba el funcionamiento de neuronas interconectadas, y lograba simular el comportamiento de ratas que aprenden a orientarse en un laberinto. La máquina, con sus 40 neuronas, fue uno de los primeros dispositivos electrónicos construidos con capacidad de aprender.

Apenas cinco años más tarde, en 1956, tuvo lugar la mítica convención de Dartmouth (New Hampshire, EE. UU.), en la que participaron figuras legendarias de la informática como John McCarthy, Marvin Minsky, Claude Shannon, Herbert Simon y Allen Newell, todos ellos ganadores del premio Turing, el más prestigioso en computación, equivalente al Nobel --galardón que, además, ganó Simon--.

Dartmouth marca un hito porque es en este encuentro donde se define la Inteligencia Artificial y se establecen las bases para su desarrollo, identificando preguntas clave que incluso hoy día nos sirven de mapa conceptual a los investigadores en esta área (Ver recuadro Las siete cuestiones fundacionales de la IA).

Es en Dartmouth donde McCarthy acuña el término de Inteligencia Artificial, para referirse a "la disciplina dentro de la Informática o la Ingeniería que se ocupa del diseño de sistemas inteligentes", esto es, sistemas con la capacidad de realizar funciones asociadas a la inteligencia humana como percibir, aprender, entender, adaptarse, razonar e interactuar imitando un comportamiento humano inteligente.

¿Algún gato en la imagen?

McCarthy quiso diferenciar la Inteligencia Artificial del concepto de cibernética, impulsado por Norbert Wiener --también profesor del MIT--, y en el que los sistemas inteligentes se basan en el reconocimiento de patrones, la estadística, y las teorías de control y de la información. McCarthy, en cambio, quería enfatizar la conexión de la Inteligencia Artificial con la lógica. Esta diferencia dio lugar a dos escuelas distintas dentro del desarrollo de la IA, como explico más adelante.

Para conseguir que un ordenador aprenda, por ejemplo, a identificar gatos en imágenes, podemos usar distintas estrategias. La aproximación basada en la estadística y en el reconocimiento de patrones requiere mostrar al ordenador miles de fotos con gatos y sin gatos --llamamos a estos ejemplos datos de entrenamiento anotados--; así, proporcionamos a los algoritmos de reconocimiento de patrones la información que necesitan para aprender a identificar automáticamente los patrones recurrentes en las fotos con gatos, versus en las fotos sin gatos. Una vez estos algoritmos han sido entrenados con suficientes ejemplos, serán capaces de determinar si hay o no un gato en las fotos nuevas que les sean presentadas.

La aproximación basada en la lógica conllevaría la definición de una taxonomía de los animales; dentro de estos, de los mamíferos; dentro de estos, de los felinos; y dentro de estos, de los gatos, describiendo sus características. Este conocimiento, programado en el ordenador, tendría que ser lo suficientemente rico, preciso y flexible como para permitir a la máquina localizar en las imágenes las características que definen a un gato, y detectar su presencia.

En un guiño del destino, la propuesta intelectual de Wiener --basada en datos y estadística-- se ha convertido en la dominante en la Inteligencia Artificial, pero utilizando la terminología de McCarthy. Sin embargo, no adelantemos acontecimientos.

Aprendiendo a distinguir entre izquierda y derecha

Entre las más controvertidas y citadas declaraciones realizadas en los albores de la Inteligencia Artificial se cuentan las del psicólogo Frank Rosenblatt, creador del Perceptrón en el Laboratorio Aeronáutico de Cornell. El Perceptrón se presentó a la prensa en 1958, como un programa instalado en un ordenador de IBM, el 704, que por cierto ocupaba una estancia entera.

Según la crónica publicada el 8 de julio de 1958 en el New York Times, el Perceptrón habría de convertirse en "el primer ordenador capaz de pensar como el cerebro humano", equivocándose al principio, pero "volviéndose más sabio con la experiencia". Rosenblatt --señala el Times-- lo describió como el "embrión" de un ordenador en el futuro capaz de "caminar, hablar, ver, escribir, reproducirse y ser consciente de su existencia".

Fue un apreciable ejercicio de extrapolación, teniendo en cuenta que la única habilidad que el Perceptrón mostró a los medios fue aprender a distinguir entre izquierda y derecha. Al 704 se le introducían dos tarjetas, una con marcas en el lado izquierdo y la otra en el derecho; la computadora empezaba a distinguir una tarjeta de otra al cabo de 50 intentos. Rosenblatt explicó que el avance se debía a un cambio en el programa autoinducido por el propio programa, lo que implica aprendizaje.

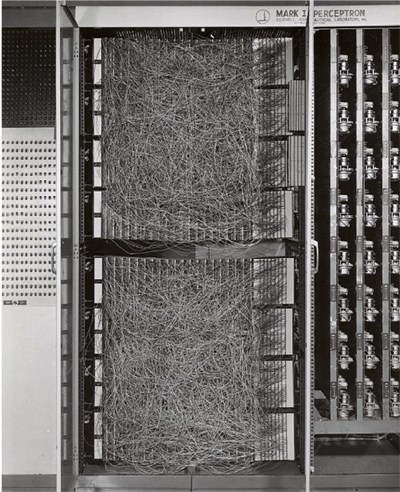

Más tarde el Perceptrón se implementó en un dispositivo propio, el Perceptrón Mark 1 (ilustrado en la Figura 4), que se aplicaba al análisis de imágenes. Rosenblatt estaba convencido que la máquina reproducía de manera simplificada el funcionamiento de neuronas que trabajan estableciendo conexiones, llamadas sinapsis, con otras neuronas.

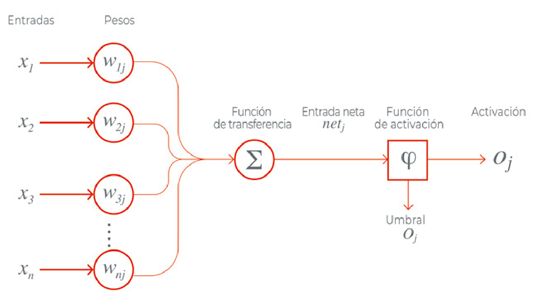

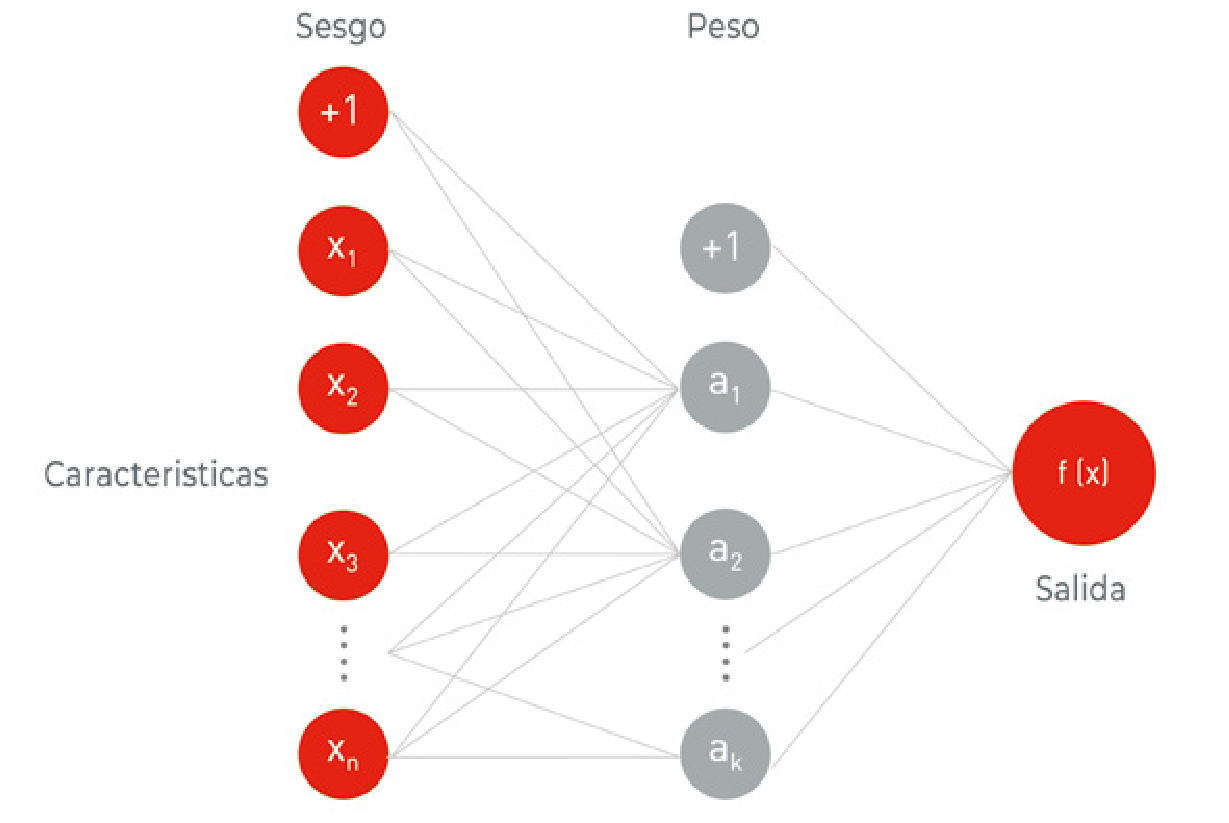

Como puede observarse en la Figura 3, el Perceptrón recibe un conjunto de valores de entrada que multiplica cada valor de entrada por un coeficiente determinado al que llamamos peso, o W1j, W2j, etc... de weight en inglés en la Figura, que representa la fuerza de la sinapsis con cada neurona adyacente; y produce una salida: 1 si la suma de las entradas moduladas por sus pesos es superior a un cierto valor, y 0 si es inferior. Las salidas 1 y 0 representan la activación o no de la neurona.

El modelo está basado en un trabajo anterior de Warren McCulloch y Walter Pitts, que demostraron que un modelo de neurona como el descrito puede representar funciones de OR/ AND/NOT. Este resultado era importante porque, como hemos explicado, en los albores de la IA se pensaba que cuando los ordenadores pudieran llevar a cabo operaciones de razonamiento lógico formal, se conseguiría la Inteligencia Artificial.

Aprender a partir de reglas, o de la experiencia

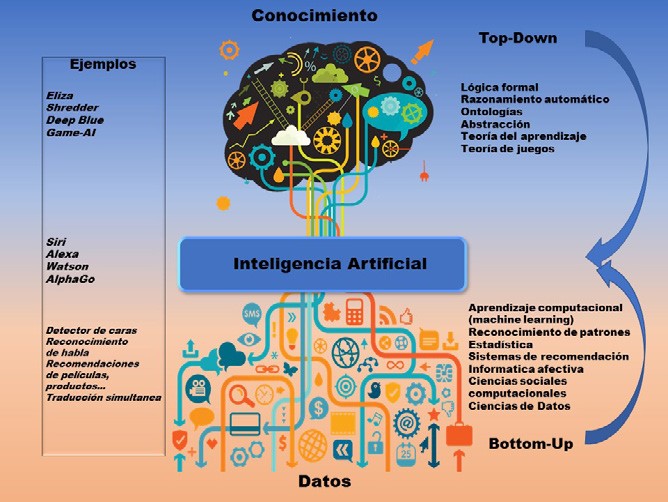

Desde las dos aproximaciones distintas a la Inteligencia Artificial por parte de Wiener (basada en datos) y McCarthy (basada en la lógica), ha existido cierto enfrentamiento entre dos escuelas de pensamiento en la Inteligencia Artificial: el enfoque simbólico-lógico o top-down -originalmente llamado neat-; y el enfoque basado en datos, conexionista o bottom-up -originalmente conocido como scruffy-.

Son abordajes muy distintos conceptualmente. El simbólico, topdown --en inglés, de arriba a abajo--, postulaba que las máquinas, para razonar, debían seguir un conjunto de reglas predefinidas y unos principios de la lógica. La idea es programar en la máquina el conocimiento que poseemos los humanos, de forma que después, aplicando las reglas que también han sido enseñadas previamente, el ordenador pueda derivar conocimiento nuevo.

El ejemplo canónico son los llamados sistemas expertos, el primer ejemplo comercial de la Inteligencia Artificial. Hablaremos de ellos más adelante.

Por su parte la escuela bottom-up --de abajo a arriba-- proponía que la Inteligencia Artificial debía inspirarse en la biología, aprendiendo a partir de la observación y de la interacción con el mundo físico, esto es, de la experiencia. Según este enfoque, si aspiramos a crear IA debemos proporcionar a los ordenadores observaciones de las que aprender. Esto conlleva entrenar algoritmos a partir de miles de ejemplos de lo que queremos que aprendan.

En los sistemas de Inteligencia Artificial suele tomarse como referencia la inteligencia humana. Del mismo modo que la inteligencia humana es diversa y múltiple, la Inteligencia Artificial es una disciplina con numerosas ramas de conocimiento, que se nutren de las dos grandes escuelas de pensamiento top-down y bottom-up.

La escuela simbólico-lógica incluye, entre otras, áreas como la teoría de juegos; la lógica; la optimización; el razonamiento y la representación del conocimiento; la planificación automática; y la teoría del aprendizaje.

En la escuela bottom-up destacaría la percepción computacional -- una de mis áreas de especialidad, que abarca el procesamiento de imágenes, vídeos, texto, audio y datos de otro tipo de sensores--; el aprendizaje automático estadístico --machine learning, otra de mis áreas--; el aprendizaje con refuerzo; los métodos de búsqueda --de texto, imágenes, vídeos--; los sistemas de agentes; la robótica; el razonamiento con incertidumbre; la colaboración humano-IA; los sistemas de recomendación y personalización; y las inteligencias social y emocional computacionales.

Primera era dorada: los sistemas expertos

Mis trabajos de investigación dentro de la IA se enmarcan en el enfoque bottom-up. Inicialmente esta escuela no tuvo mucho éxito práctico, ya que no había disponibles grandes cantidades de datos, ni la capacidad de computación necesaria para entrenar modelos suficientemente complejos como para resultar útiles. Por ello la primera aplicación práctica de la Inteligencia Artificial fue en los años 60, con los sistemas expertos, que pertenecen al enfoque simbólicológico.

En 1956, después de la convención de Dartmouth, Herbert Simon predijo que "en veinte años, las máquinas serán capaces de hacer el trabajo de una persona". Marvin Minsky, por su parte, declaró en 1970 a la revista Life que "dentro de tres a ocho años tendremos una máquina con la inteligencia general de un ser humano". Hasta mediados de los años setenta predominó el optimismo en todo lo relativo a la Inteligencia Artificial y su impacto.

De hecho, el periodo entre 1956 y 1974 suele conocerse como la primera etapa dorada de la Inteligencia Artificial. Fueron los años en que Edward Feigenbaum --uno de los fundadores del departamento de informática de la Universidad de Stanford-- lideró el equipo que construyó el primer sistema experto, implementado en LISP, el programa de ordenador desarrollado por McCarthy.

El nombre de este sistema experto era DENDRAL, y fue fruto del deseo del biólogo molecular Joshua Lederberg, también de Stanford, de disponer de un sistema que facilitara su investigación sobre compuestos químicos en el espacio. DENDRAL ayudaba a los químicos orgánicos a identificar moléculas desconocidas a partir de su espectro de masas, gracias a que le había sido transferido el conocimiento de un prestigioso químico --en concreto Carl Djerassi, creador de la píldora anticonceptiva--. DENDRAL era experto en química porque atesoraba el conocimiento químico y la experiencia de un humano experto en este campo.

Arrecia el 'primer invierno'

Pero a principios de los 70 llegó el invierno, el primer invierno de la IA. Las ambiciosas expectativas creadas durante las dos décadas anteriores no se cumplieron. Además, en 1969 fue publicado el libro Perceptrons, de Minsky y Seymour Papert, a quienes tuve el honor de conocer durante mis años en el MIT. Esta obra contribuyó a desinflar aún más el interés por los modelos bottom-up y, en particular, por las redes neuronales.

En Perceptrons se demostraba que los perceptrones eran muy limitados porque solo pueden aprender funciones extremadamente simples o, expresado en términos más matemáticos, funciones linealmente separables.

Desgraciadamente, la gran mayoría de los problemas del mundo real son complejos, y no cumplen la condición de ser linealmente separables. En concreto, Minsky y Papert mostraban que los perceptrones no aprenden ni siquiera la función XOR, ilustrada en la Figura 6, que es la más sencilla de las que no pueden separarse con una línea.

La función XOR (de exclusive OR en inglés, o disyunción exclusiva) es una operación lógica que es 1 solo cuando los valores de entrada son distintos (es decir 1 y 0, o 0 y 1), y es 0 cuando los valores de entrada son iguales (1 y 1 o 0 y 0). En términos generales, XOR devuelve un 1 cuando tiene un número impar de valores de entrada que valen 1, y devuelve 0 en caso contrario.

Pese a su sencillez, XOR no es linealmente separable: si representamos los valores (0,0) (1,1) (0,1) y (1,0) en un gráfico, es imposible separar con una recta el (0,0) (1,1) del (0,1) (1,0) para reflejar que XOR devuelve 0 para (0,0) (1,1) y devuelve 1 para (0,1) (1,0). Para poder representar XOR, o cualquier otra función no linealmente separable, se necesitan modelos más complejos que un simple perceptrón.

Por tanto, los investigadores en Inteligencia Artificial se encontraron con limitaciones y dificultades insalvables en la década de los 70. La escasa capacidad de computación de las máquinas impedía procesar grandes cantidades de datos, algo indispensable para entrenar modelos complejos con que abordar problemas reales. Hace apenas una década, o poco más, que hemos comenzado a solventar este reto.

Dichas limitaciones, combinadas con grandes expectativas incumplidas, dieron lugar a un declive tanto en el interés como en la financiación de la Inteligencia Artificial durante el periodo entre 1974 y 1980. El invierno había llegado.

El inasible sentido común

Pero tarde o temprano llega la primavera. El interés por la Inteligencia Artificial, y los fondos disponibles para su desarrollo, empezaron a aumentar de nuevo a principios de los 80. Durante esa década llegaron al mercado los primeros sistemas expertos, con éxito apreciable. En 1985 el gasto en sistemas de IA en las empresas era de miles de millones de dólares.

Dentro del acercamiento simbólico-lógico, en 1984 nació el primer esfuerzo científico por implementar en una máquina el razonamiento de sentido común, mediante una gigantesca base de datos con todo el conocimiento sobre el mundo que tiene, de media, una persona. Llamado Cyc, hoy en día sigue activo en la compañía Cycorp y atesora decenas de millones de aserciones, reglas o ideas del sentido común aportadas por humanos --por ejemplo, el agua causa humedad y la humedad pudre la comida--, que pueden ser usadas por otros programas.

Sin embargo, de nuevo aparecieron obstáculos. Durante el congreso de 1984 de la Asociación Americana de Inteligencia Artificial, Minsky y Roger Schank alertaron de que el entusiasmo y la inversión en Inteligencia Artificial conducirían a una nueva decepción. En efecto, en 1987 comenzó el segundo invierno de la Inteligencia Artificial, que alcanzaría su momento más oscuro en 1990.

Mientras tanto la comunidad científica seguía avanzando en las dos escuelas de pensamiento. Uno de los hitos más importantes de la estrategia bottom-up y, en particular, del conexionismo, fue el uso del algoritmo de backpropagation por parte de David Rumelhart, Geoffrey Hinton y Ronald Williams [17] en 1986.

Entrenando máquinas a partir de datos: el resurgir del conexionismo

Gracias al algoritmo de backpropagation es posible entrenar redes mucho más complejas que el Perceptrón, con numerosas capas de neuronas ocultas --llamadas así en la jerga-- operando entre las capas de entrada y salida y con capacidad, esta vez sí, de modelar problemas complejos. Hoy en día el algoritmo de backpropagation es la base de la gran mayoría de modelos de redes neuronales profundas.

El funcionamiento, en términos muy básicos, es el siguiente. Las redes nacen ignorantes, no saben nada sobre el problema que tienen que resolver a partir de los datos que se les van a proporcionar --volviendo al ejemplo de los gatos, no saben si hay o no un gato en la foto--, pero se lanzan y hacen una predicción; esa predicción es cotejada con la realidad, y se mide su grado de error. En función de esta medida se ajustan los pesos en la red, es decir, los coeficientes que deben ser procesados por la neurona.

Se llama backpropagation porque se propagan los errores hacia atrás en la red, desde las neuronas de salida (las que están más a la derecha en la Figura 7), a las neuronas de entrada. Por tanto, los errores que comete la red neuronal al entrenarse sirven, gracias al algoritmo backpropagation, para determinar los valores de los pesos que lograrían reducir tales errores. Es un proceso iterativo: en cada iteración se van ajustando los pesos en función de los errores cometidos, de forma que estos, y la propia corrección a que se les debe someter, se van reduciendo (ver ejemplo en la Figura 8).

Aunque Rumelhart, Hinton y Williams no fueron los primeros en publicar un artículo sobre backpropagation, fue su trabajo el que logró calar en la comunidad científica por la claridad con que presenta esta idea.

Igualmente cabe destacar el trabajo de Judea Pearl a finales de los 80, cuando incorporó a la Inteligencia Artificial las teorías de la probabilidad y de la decisión. Algunos de los nuevos métodos propuestos incluyen modelos clave en mi investigación, como las redes bayesianas (una red bayesiana es un modelo gráfico probabilístico que representa una serie de variables y sus dependencias probabilísticas en forma de un gráfico donde los nodos son las variables, y las conexiones entre nodos representan las dependencias entre variables) y los modelos ocultos de Markov (un modelo estadístico de un sistema dinámico que puede representarse como la red bayesiana dinámica más sencilla), así como la teoría de la información, el modelado estocástico y la optimización. También se desarrollaron los algoritmos evolutivos, inspirados en conceptos de la evolución biológica como la reproducción, las mutaciones, la recombinación de genes y la selección.

En los algoritmos evolutivos se generan soluciones candidatas al problema que se quiere resolver. Cada solución juega el papel de un individuo en una población; se van seleccionando las soluciones de mayor calidad aplicando ciertos criterios predefinidos, y estas soluciones se hacen evolucionar aplicando los conceptos anteriores de reproducción, mutaciones, etcétera.

El objetivo es que, tras un cierto número de generaciones, las soluciones encontradas sean cada vez mejores. La ventaja es que estos algoritmos se pueden aplicar para resolver multitud de problemas. La desventaja es su complejidad computacional, que dificulta su aplicación a muchos problemas reales.

Desde mediados de los años 90, precisamente cuando comencé mi doctorado en el MIT, hasta hoy en día --y especialmente en la última década--, se ha producido un avance muy significativo en las técnicas de aprendizaje estadístico por ordenador basadas en datos (statistical machine learning), que pertenecen al enfoque bottom-up.

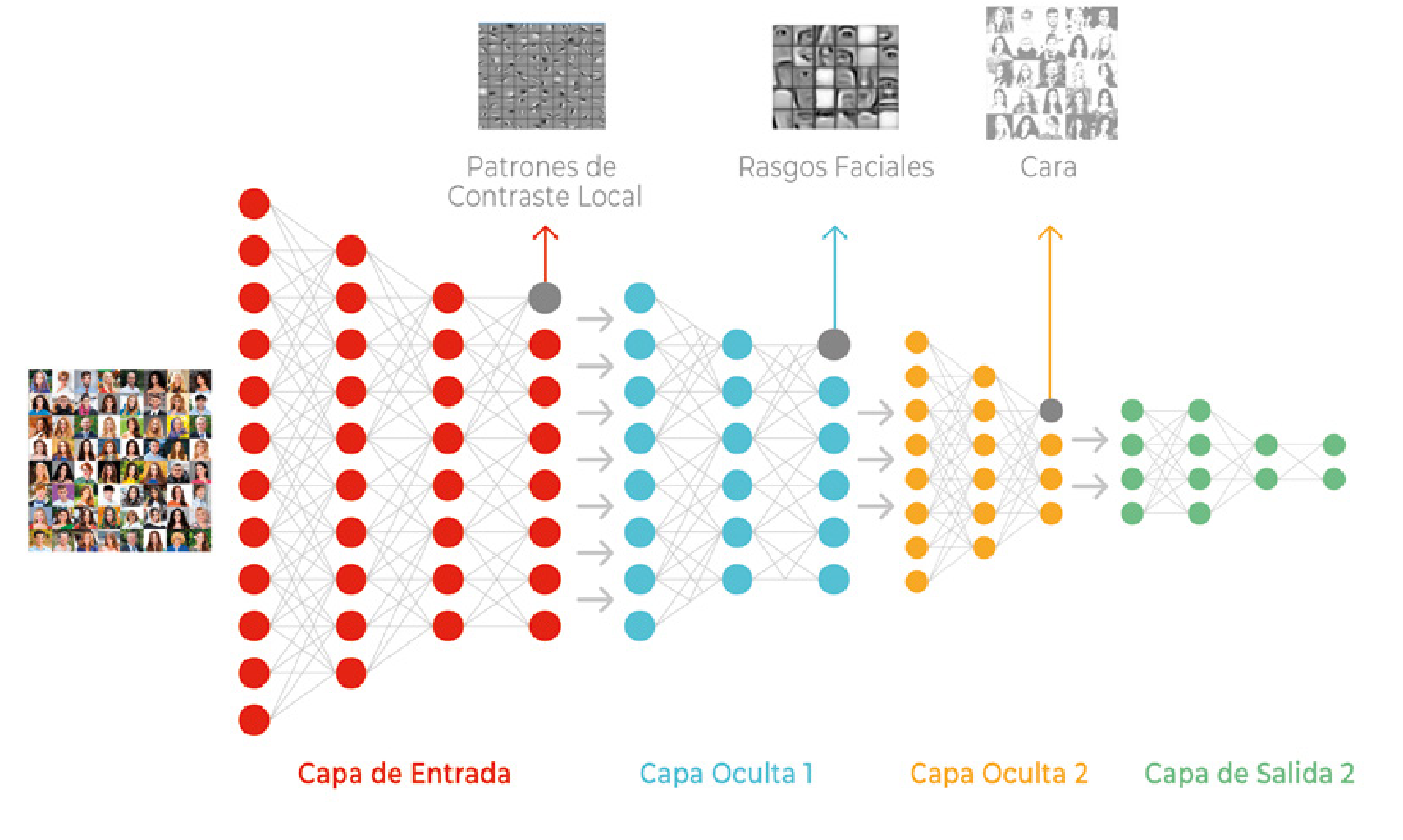

El acceso a cantidades ingentes de datos --Big Data--; la disponibilidad de procesadores muy potentes a bajo coste; y el desarrollo de redes neuronales profundas y complejas, los modelos llamados de deep learning [18] (ver Figuras 8 y 9), son los tres factores que han confluido para instalar hoy día a la Inteligencia Artificial en una "primavera perpetua", en palabras del profesor de la Universidad de Stanford Andrew Ng, con quien también coincidí en MIT.

En los últimos años --como puede observarse en la Figura 10--, con el éxito de los métodos de aprendizaje de deep learning se ha producido un fuerte resurgir del acercamiento bottomup y en particular del conexionismo, dentro de la Inteligencia Artificial. Así lo atestigua el hecho de que los pioneros del deep learning Yoshua Bengio, Geoffrey Hinton y Yann LeCun hayan recibido en 2019 el premio Turing, el equivalente al Nobel en informática.

La Inteligencia Artificial --no queda ya alguna duda-- forma parte de nuestro presente. De ello hablaremos a continuación.

LAS SIETE CUESTIONES FUNDACIONALES DE LA IA

En 1955, investigadores pioneros en Inteligencia Artificial propusieron analizar en la Conferencia de Dartmouth (New Hampshire, EE.UU.) la conjetura de que, en principio, todos los aspectos del aprendizaje humano, y en general de la inteligencia, pueden ser descritos de manera lo bastante precisa como para que una máquina pueda simularlas. Desmenuzaron en siete cuestiones el desafío de lograr una Inteligencia Artificial, muchas de las cuales perduran hoy en día como retos a abordar:

- Capacidad computacional: "La velocidad y memoria de los ordenadores actuales podría ser insuficiente para simular muchas de las funciones superiores del cerebro humano, pero el principal obstáculo no es la falta de capacidad de las máquinas, sino nuestra incapacidad para programar (...)", escribieron John McCarthy, Marvin Minsky, Claude Shannon y Herbert Simon.

- Lenguaje. Los humanos, en gran parte, usamos palabras para pensar. ¿Se puede programar a un ordenador para que tenga lenguaje --y pueda, por ejemplo, integrar términos nuevos en frases con significado, como hacemos nosotros--?

- Capacidad de abstracción en las redes neuronales: ¿Cómo se puede disponer una red de hipotéticas neuronas para lograr que formen conceptos?

- ¿Es eficiente esta manera de resolver el problema? Los expertos echaban en falta un método para dimensionar una operación computacional, para decidir si abordarla o por el contrario buscar otras estrategias.

- Superarse a uno mismo. "Probablemente una máquina verdaderamente inteligente llevará a cabo tareas que pueden ser descritas como de superación personal".

- Pensamiento abstracto. "Puede valer la pena hacer un intento de clasificar las abstracciones, y describir métodos por los que las máquinas podrían generar abstracciones a partir de estímulos sensoriales y otros datos".

- Aleatoriedad y creatividad. "Una conjetura atractiva, y sin embargo claramente incompleta, es que la diferencia entre el pensamiento creativo y el pensamiento competente poco imaginativo reside en la introducción de una cierta aleatoriedad".

IA hoy en día

La IA ya transforma nuestras vidas

Si la electricidad impulsó la Segunda Revolución Industrial, e internet y los ordenadores personales la Tercera, la Inteligencia Artificial está provocando la Cuarta. Los sistemas de IA están transformando la medicina, el transporte, el sector energético, nuestra elección de contenidos de cultura y ocio, la economía en su conjunto y por supuesto la ciencia, a pasos agigantados. Pese a sus limitaciones, y a que queda aún muy lejos el sueño de una inteligencia equiparable a la humana, todo apunta a que en poco tiempo el planeta estará envuelto en un sistema circulatorio que lo irrigará capilarmente con Inteligencia Artificial.

"Soy un ser humano. Me asusto cuando veo algo que supera con mucho mi capacidad de comprensión", declaró el campeón mundial de ajedrez Gary Kasparov tras su derrota contra el programa Deep Blue, de IBM, el 11 de mayo de 1997[19]. Era la primera vez que un campeón de ajedrez perdía contra una máquina. "Enérgica y brutalmente, el ordenador Deep Blue de IBM arrebató a la humanidad, al menos temporalmente, el puesto de mejor ajedrecista del planeta", decía el New York Times al inicio de su crónica.

La gran repercusión mediática de este logro de la Inteligencia Artificial, impensable hace solo tres décadas, ha contribuido al exorbitante aumento en el interés por esta disciplina.

Pero hay muchos más hitos. En 2005 un vehículo autónomo desarrollado en la Universidad de Stanford, EE. UU., recorrió autónomamente 212 kilómetros en el desierto y se convirtió así en el primero en superar el DARPA Grand Challenge[20], una carrera de vehículos sin conductor creada solo un año antes por la Agencia de Investigación en Proyectos Avanzados de Defensa estadounidense, más conocida por su acrónimo DARPA. Este hito demostró que la conducción autónoma era posible y fue el punto de partida de los miles de millones de dólares de inversión en la conducción sin conductor.

Poco más tarde, en 2011, el programa de IA Watson, de IBM, venció a dos de los campeones humanos del concurso estadounidense de preguntas y respuestas Jeopardy![21]. Ese fue el año en que muchos de nosotros empezamos a hablar con asistentes personales instalados en nuestros teléfonos móviles --Siri, Cortana y Google Now--, programas que permiten a sus usuarios utilizar la voz y el lenguaje natural para hacer preguntas y dar instrucciones, y que desde 2015 están también en nuestro hogar --Alexa, Google Home--.

En 2016 otro enfrentamiento hombre-máquina, con victoria para el contendiente no biológico, conquistó portadas en todo el planeta.

El programa AlphaGo, desarrollado por la compañía DeepMind, de Google, venció en el juego chino Go a uno de los mejores jugadores humanos del mundo, Lee Sedol[22]. Las reglas del Go son más simples que las del ajedrez, pero el número de configuraciones a tener en cuenta es mucho mayor. Además, el juego requiere grandes dosis de intuición, por lo que dominarlo parecía del todo imposible para una máquina. AlphaGo solo pudo lograrlo recurriendo a su capacidad de aprendizaje, mucho más desarrollada que la de Deep Blue.

También aprendió mucho el programa de la Universidad Carnegie Mellon Libratus cuando, en enero de 2017, se enfrentó al póker a cuatro de los mejores jugadores del mundo. Al concluir veinte días de torneo las ganancias de Libratus superaban en 1,7 millones de dólares las de los humanos[23]. Fue una victoria relevante, porque el póker representa un nivel adicional de complejidad: en el ajedrez y en el Go el tablero, con todas sus piezas, es visible para ambos jugadores, mientras que en el póker desconocemos las cartas de nuestros contrincantes, que, además, pueden marcarse faroles. Es decir, el póker es un juego de información incompleta y por tanto mucho más difícil de jugar computacionalmente.

Otros hitos recientes se producen en los combates máquinamáquina. En diciembre de 2017 AlphaZero, de DeepMind, no solo venció al mejor jugador de ajedrez del mundo --que por cierto es un programa de ordenador llamado Stockfish--, sino que hizo gala de su capacidad de aprender el juego por sí solo[24]. Ambos programas se enfrentaron en una serie de cien partidas, de las que AlphaZero ganó 28 y el resto quedaron en tablas; para lograr la hazaña, al programa de DeepMind le bastó conocer las reglas del ajedrez y dedicar cuatro horas a entrenarse, jugando contra sí mismo millones de veces.

No menos relevante es que un sistema de procesamiento de lenguaje desarrollado por Alibaba --la gran compañía china de comercio electrónico-- superara en 2018 los resultados de los humanos en la prueba de comprensión lectora de la Universidad de Stanford (EE. UU.)[25]. El Stanford Question Answering Dataset es un conjunto de cien mil preguntas, que hacen referencia a más de 500 artículos de Wikipedia.

En la salud, el ocio, la seguridad, la economía...

Más allá de estos hitos, que pueden parecer alejados de la aplicación práctica, la Inteligencia Artificial ocupa ya un lugar importante en multitud de esferas de nuestra vida. Convivimos con la IA probablemente sin saberlo. Está presente en los sistemas de búsqueda y recomendación de información, contenido, productos o amigos que utilizamos en nuestro día a día, como Netflix, Spotify, Facebook, y en cualquier servicio de noticias o de búsqueda en internet. También en las aplicaciones para la cámara del móvil que detectan automáticamente las caras en las fotos; en los asistentes personales de móviles y hogares; en chatbots conversacionales; y en las ciudades inteligentes, para por ejemplo predecir el tráfico.

La IA interviene en la compraventa de acciones, la adjudicación de créditos, la contratación de seguros y la fijación de tarifas, entre otras muchas decisiones que marcan el ritmo de los mercados financieros y las empresas. En el ámbito de la salud funcionan ya los sistemas de diagnóstico automático a partir de historiales clínicos, así como programas de análisis de imágenes médicas, para asistir el diagnóstico radiológico, y de ADN, para por ejemplo detectar mutaciones o variantes genéticas asociadas a enfermedades.

La toma de decisiones de las Administraciones Públicas se apoya igualmente en la Inteligencia Artificial, con sistemas de vigilancia, de soporte a decisiones judiciales o de clasificación y jerarquización del alumnado. Numerosas aplicaciones se destinan al ámbito de la seguridad y la defensa, desde en el control de viajeros en las fronteras y la adjudicación de visados, hasta para fabricar armas autónomas.

La industria, y en general los procesos productivos, llevan décadas utilizando robots industriales, al igual que sistemas de planificación y predicción de la demanda o de la producción.

Y, por supuesto, sin el apoyo de la Inteligencia Artificial no podríamos soñar con tener vehículos autónomos, una predicción meteorológica certera a medio plazo ni, en general, avances en numerosas áreas de conocimiento. La IA empieza a convertirse en un actor importante de la investigación científica, interviniendo en modelos físicos de toda clase de fenómenos y procesos, en la predicción de la estructura tridimensional de las proteínas, en el diseño de fármacos... La lista es larga.

No hay duda de que la IA tiene un potencial inmenso para construir una sociedad mejor, y ese es el motor de mi trabajo.

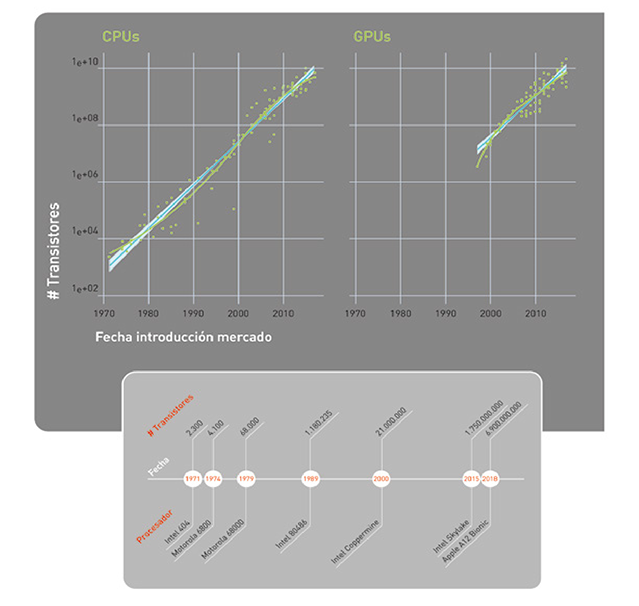

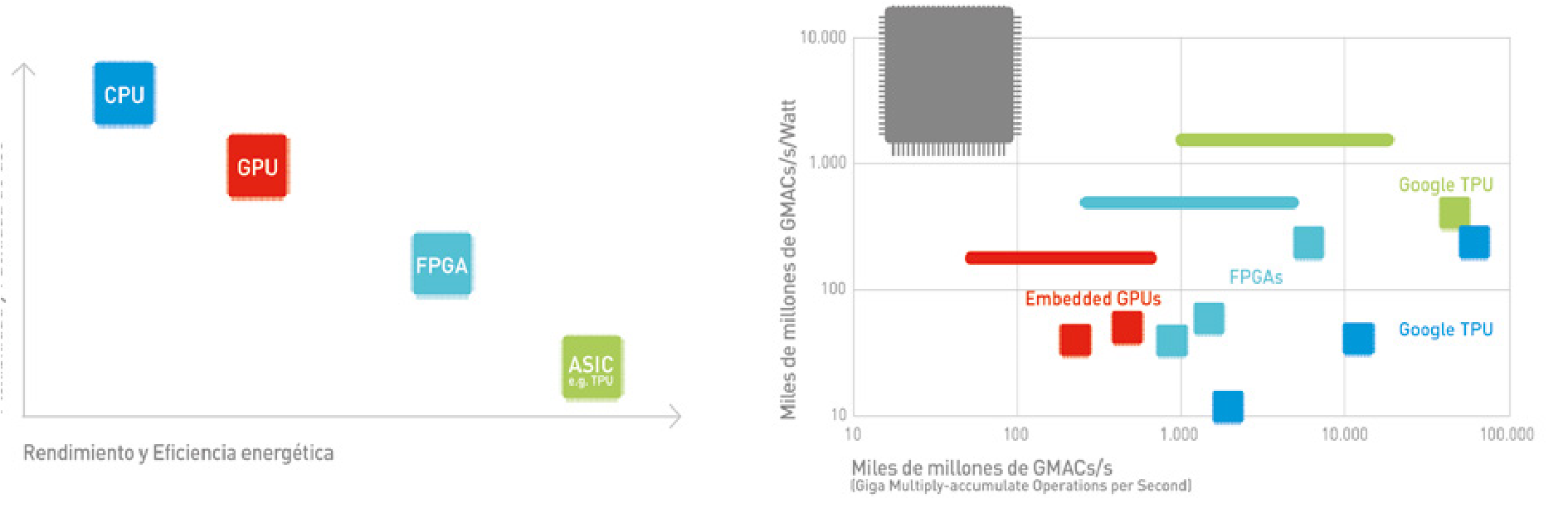

El sustrato físico

Si en la evolución humana el aumento de la capacidad cognitiva va de la mano de cambios biológicos, también la inteligencia de las máquinas depende del sustrato físico en que se implementa. No solo de software vive la Inteligencia Artificial. En el desarrollo de la IA, tanto en sus aplicaciones prácticas como en la consecución de los hitos antes descritos, han tenido un papel clave los avances en el hardware, en particular en los sistemas de procesamiento y almacenamiento a gran escala, distribuidos y en paralelo.

Sin los potentes procesadores actuales tampoco existirían hoy los complejos modelos de deep learning o aprendizaje profundo, basados en redes neuronales con muchas capas de procesado de información (ver Figuras 9 y 10). Es el nuevo hardware, a menudo

optimizado para esta tarea específica, el que permite entrenar a los modelos, alimentándolos con grandes cantidades de datos en un tiempo y con un consumo energético razonables.

En los últimos años hemos pasado de utilizar procesadores de propósito general (CPUs y GPUs o graphics processing units) a procesadores especializados, optimizados para este tipo de modelos de IA (FPGAs o field-programmable gate arrays y ASICs o application-specific integrated circuits, como la TPU desarrollada por Google). Las figuras 11 y 12 ilustran la evolución en la capacidad de computación. La Figura 11 muestra la famosa Ley de Moore desde 1971, según la cual el número de transistores que podemos integrar en un circuito por el mismo precio se duplica cada año, o año y medio.

La parte de la izquierda representa la Ley de Moore en CPUs, y la derecha en GPUs. En la Figura 12 se ve dónde se sitúan los distintos tipos de procesadores en función de su flexibilidad y facilidad de uso, versus su eficiencia energética y rendimiento.

El lector interesado puede encontrar un resumen de los principales procesadores utilizados para el aprendizaje automático en [26]. Tampoco podemos obviar que transmitir y procesar las enormes cantidades de datos con que se trabaja hoy día requiere un elevadísimo consumo energético (Ver recuadro ¿Un planeta inteligente poco sostenible?).

¿UN PLANETA INTELIGENTE PERO POCO SOSTENIBLE?

El consumo energético de la Inteligencia Artificial representa un desafío creciente para la sostenibilidad del planeta. Los centros de datos y sistemas de IA requieren cantidades masivas de electricidad, tanto para el procesamiento como para la refrigeración. Estudios recientes estiman que el entrenamiento de un único modelo grande de IA puede generar más de 550 toneladas de CO~2~ (como en el caso de GPT-3), equivalente a cinco veces las emisiones totales de un automóvil durante toda su vida útil[27]. A medida que la IA se vuelve más ubicua, la necesidad de mejorar drásticamente la eficiencia energética de los procesadores y desarrollar fuentes de energía renovables se vuelve cada vez más urgente para evitar que el progreso tecnológico comprometa nuestros objetivos climáticos.

No podemos obviar la demanda energética que conllevaría una implantación masiva de los sistemas de Inteligencia Artificial. Por ello, y siempre desde la perspectiva del desarrollo y adopción de la Inteligencia Artificial para el bien social, hemos de invertir en investigación e implementación de soluciones que sean sostenibles desde el punto de vista medioambiental.

Necesitamos apoyarnos en algoritmos de Inteligencia Artificial para modelar el clima, por ejemplo, o construir modelos predictivos del cambio climático o del consumo energético. Pero también hemos de considerar el impacto medioambiental del desarrollo de la Inteligencia Artificial.

El campeón de ajedrez que desconoce qué es el ajedrez

El despliegue de los hitos de la Inteligencia Artificial durante la última década puede resultar abrumador, incluso inquietante. Basta una pregunta para ganar perspectiva y reconsiderar la situación: ¿sabe Libratus que está jugando --y ganando-- al póker?

Los sistemas de Inteligencia Artificial suelen dividirse en tres tipos, atendiendo a su grado de competencia. La IA específica hace referencia a sistemas capaces de realizar una tarea concreta, como jugar al ajedrez, reconocer el habla, imágenes o procesar texto, incluso mejor que un humano. Pero solamente saben hacer esa tarea. Este es el tipo de Inteligencia Artificial que tenemos hoy en día.

Los sistemas con IA general, en cambio, exhiben una inteligencia similar a la humana: múltiple, adaptable, flexible, eficiente, incremental... Esta sería la aspiración última de la Inteligencia Artificial, y estamos aún muy lejos de hacerla realidad.

La tercera categoría corresponde a los sistemas con súper-inteligencia, término un tanto controvertido referido al desarrollo de sistemas con inteligencia superior a la humana, tal y como propone el filósofo de la Universidad de Oxford, Reino Unido, Nick Bostrom [28].

En la actualidad disponemos de sistemas de Inteligencia Artificial específica, es decir, capaces de realizar automática y autónomamente

una tarea concreta, pero esa y solo esa. Aunque un algoritmo juegue mejor que el mejor de los humanos, es incapaz de hacer cualquier otra tarea. De hecho, tampoco sabe qué es el ajedrez, y tendría dificultades para jugar si introdujéramos cambios en las reglas.

Los sistemas actuales manifiestan un tipo limitado de inteligencia: son incapaces, entre otras cosas, de generalizar y extender a otros ámbitos sus niveles de competencia en una tarea de manera automática, como haría un humano.

Inteligencia Artificial 'versus' Inteligencia Humana

El éxito reciente de los sistemas de Inteligencia Artificial quizás esté desviando la atención respecto al grado de avance en cuestiones profundas del área. Hay problemas fundacionales de la Inteligencia Artificial que todavía están por resolver.

Algunos de estos problemas derivan de tres limitaciones básicas, tres aspectos que marcan la diferencia entre los mecanismos de aprendizaje automático disponibles actualmente y los sistemas inteligentes biológicos. Lo explica Jeff Hawkins en un artículo para IEEE Spectrum [29] que resumo en los siguientes párrafos.

Los sistemas de aprendizaje biológicos --cerebros-- son capaces de aprender rápidamente. Unas pocas observaciones o experiencias táctiles suelen ser suficientes para aprender algo nuevo, a diferencia de los millones de ejemplos que necesitan los sistemas de Inteligencia Artificial actuales.

Además, los sistemas biológicos aprenden de manera incremental, es decir, agregamos conocimiento nuevo sin tener que volver a aprender todo desde cero ni perder conocimiento anterior. Es más, hacemos todo lo anterior de manera continua. Aprendemos conforme interaccionamos con el mundo físico, y nunca dejamos de hacerlo. El aprendizaje rápido, incremental y constante es un elemento esencial que permite a los sistemas biológicos inteligentes adaptarse a un entorno cambiante, y sobrevivir.

La neurona es un elemento clave en el aprendizaje biológico. La complejidad de las neuronas biológicas y sus conexiones es lo que dota al cerebro de la capacidad para aprender. Hoy sabemos que el cerebro tiene plasticidad y que constantemente se están creando nuevas neuronas --el fenómeno llamado neurogénesis-- y sinapsis --sinaptogénesis--. Se estima que diariamente se sustituyen hasta un 40% de las sinapsis en cada neurona, lo que implica que hay en marcha un proceso constante de creación de nuevas conexiones neuronales.

Los sistemas de aprendizaje artificiales no tendrían por qué reproducir exactamente el funcionamiento de las neuronas biológicas, pero esta capacidad para disponer de un aprendizaje rápido, incremental y constante, caracterizado por la destrucción y creación de sinapsis, es esencial.

Otra cuestión clave es que el cerebro procesa la información mediante representaciones distribuidas no densas, o dispersas (sparse distributed representations o SDRs) [30], una terminología referida a que solo un conjunto reducido de neuronas está activo en cada momento del tiempo. Este grupo de neuronas encendidas cambia de un instante a otro en función de lo que haga el ser vivo, pero es en cualquier caso pequeño.

Esta configuración con representaciones distribuidas de la información es robusta respecto a los errores y a la incertidumbre. Además, goza de dos propiedades interesantes: la propiedad del solape, que permite detectar rápidamente si dos percepciones son idénticas o diferentes; y la propiedad de la unión, que permite al cerebro mantener varias representaciones en paralelo.

Por ejemplo, si oímos un animal que se mueve entre unos arbustos, pero no hemos podido verlo, podría ser un conejo, una ardilla o una rata. Dado que las representaciones en el cerebro son dispersas, nuestro cerebro puede activar tres SDRs al mismo tiempo -la del conejo, la ardilla y la rata- sin interferencias entre ellas. Gracias a esta propiedad de poder unir SDRs el cerebro gestiona, opera y toma decisiones aún sin disponer de información completa, es decir, con incertidumbre.

Además, el aprendizaje tiene cuerpo. Nuestro cerebro recibe la información de los distintos sentidos, y esta información cambia según nos movemos y actuamos en nuestro entorno.

Un sistema de Inteligencia Artificial no tiene por qué tener un cuerpo físico, pero sí la capacidad de actuar sobre su entorno físico y virtual, y recibir una reacción --feedback-- a sus acciones. Los sistemas de aprendizaje con refuerzo -reinforcement learning- hacen algo similar, y son instrumentales en la consecución de algunos de los hitos previamente descritos, como los logrados por AlphaZero.

El cerebro es capaz de integrar la información captada por los distintos sentidos y por el sistema motor, para poder no sólo procesar, reconocer y decidir en función de lo percibido, sino también actuar. Esta integración sensorial-motora es básica en el funcionamiento del cerebro y probablemente deberá también serlo en los sistemas de Inteligencia Artificial.

Finalmente, en el cerebro la información sensorial es procesada por un sistema jerárquico: conforme la información va pasando de un nivel a otro se van calculando características cada vez más complejas y abstractas de lo que se está percibiendo.

Los modelos de aprendizaje profundo también utilizan jerarquías, pero mucho más complicadas de las empleadas por el cerebro humano, con decenas o una centena de niveles y centenas o miles de millones de parámetros. Estas redes neuronales profundas --modelos de deep learning-- necesitan millones de observaciones para aprender un patrón. A nuestro cerebro, en cambio, le bastan pocos niveles de jerarquías y también, como ya he dicho, pocos ejemplos para aprender. El cerebro aprende de manera mucho más eficiente que los modelos computacionales de hoy en día.

Estas limitaciones, sin embargo, no están frenando el creciente impacto de la Inteligencia Artificial en nuestras vidas. La IA es ya un elemento integral de la Cuarta Revolución Industrial en la que estamos inmersos.

Podemos imaginar escenarios sin precedente en la historia de la humanidad. Escenarios donde, por ejemplo, una red de sistemas de IA podría muy rápidamente incorporar los últimos métodos computacionales en el diagnóstico de una enfermedad, y desplegarlos a toda la población del planeta. El equivalente analógico, que consistiría en una incorporación casi instantánea del conocimiento a todos los médicos del planeta, es simplemente inviable.

La Cuarta Revolución Industrial

En los últimos tres siglos hemos vivido cuatro revoluciones industriales, ilustradas en la Figura 12. La primera tuvo lugar entre los siglos XVIII y XIX en Europa y Norteamérica, y se corresponde con el momento histórico en que sociedades que eran mayoritariamente agrarias y rurales se convirtieron en industriales y urbanas. El principal factor impulsor de esta revolución fue la invención de la máquina de vapor, junto con el desarrollo de las industrias textil y metalúrgica.

La Segunda Revolución Industrial --conocida como la Revolución Tecnológica-- ocurrió justo antes de la Primera Guerra Mundial, entre 1870 y 1914, y se corresponde con un crecimiento de las industrias anteriores y el desarrollo de otras nuevas, como la del acero y el petróleo, y con la llegada de la electricidad. Los avances tecnológicos más importantes de esta revolución incluyen el teléfono, la bombilla, el fonógrafo y el motor de combustión interna.

La Tercera Revolución Industrial es la Revolución Digital y hace referencia a la transición de dispositivos mecánicos y analógicos al uso de tecnologías digitales. Comenzó en los años 80 y continúa hoy en día. Los avances tecnológicos clave incluyen los ordenadores personales, internet y el desarrollo de otras tecnologías de la información y las comunicaciones (TICs).

Finalmente, la Cuarta Revolución Industrial se apoya en avances de la Revolución Digital, pero incorpora la ubicuidad de la tecnología digital tanto en nuestra sociedad como en nuestro cuerpo, y la unión creciente entre los mundos físico, biológico y digital.

Los avances tecnológicos que hacen posible esta nueva revolución incluyen la robótica, la Inteligencia Artificial --alimentada con Big Data-- la nanotecnología, la biotecnología, la ingeniería genética, el internet de las cosas, los vehículos autónomos, las impresoras en tres dimensiones y la informática cuántica. El término fue presentado y reconocido globalmente durante el Foro Económico Mundial en 2016 por su fundador, el economista alemán Klaus Schwab.

Una IA transversal e invisible

La Inteligencia Artificial tiene un conjunto de características que contribuyen a convertirla en un elemento clave en esta Cuarta Revolución Industrial. Para empezar, es transversal e invisible.

Las técnicas de Inteligencia Artificial, como hemos explicado, pueden utilizarse en un sinfín de aplicaciones en medicina, energía, transporte y educación; en la investigación científica, en los sistemas de producción, la logística, los servicios digitales y la prestación de servicios públicos y privados. Y en la gran mayoría de estas aplicaciones, los sistemas de IA consisten en software instalado en el corazón de aplicaciones y servicios. Es decir, son invisibles. Estas dos propiedades, la transversalidad y la invisibilidad, sitúan a la Inteligencia Artificial en el núcleo de la Cuarta Revolución Industrial, con un papel similar al jugado por la electricidad en la Segunda Revolución Industrial.

Otras características de la IA son la complejidad, la escalabilidad y la actualización constante. Los sistemas actuales de Inteligencia Artificial basados en modelos de aprendizaje profundo son complejos, con cientos de capas de neuronas y millones de parámetros. Esta complejidad tiene un doble filo.

Por una parte, dificulta la interpretación de los modelos, lo que, en ciertas aplicaciones, por ejemplo, en medicina o en educación, es un obstáculo limitante. Pero al mismo tiempo es esta complejidad la que permite a la Inteligencia Artificial procesar cantidades ingentes

de datos, y realizar tareas con niveles de competencia superiores a los de los humanos. Es decir, los complejos modelos de aprendizaje profundo dotan a los sistemas de IA de gran escalabilidad.

En muchos casos solo podemos extraer conocimiento y valor del Big Data a través del uso de sistemas de Inteligencia Artificial, ya que los métodos tradicionales no pueden procesar volúmenes de datos tan grandes que, además, son variados, generados a gran velocidad y no estructurados --es decir, son texto, audio, vídeo, imágenes o proceden de sensores--. Para los sistemas de Inteligencia Artificial esto no es un problema gracias a que son altamente escalables, esto es, consisten fundamentalmente en software que puede estar conectado con miles o millones de otros sistemas de IA, dando lugar a una red colectiva.

Hoy en día, sin IA seríamos incapaces de analizar e interpretar las enormes cantidades de texto, imágenes, audio o vídeo que existen. Entre otras cosas, no podríamos buscar información en internet. En astronomía, física, biología, química, meteorología o medicina cada vez generamos más datos, datos a los que, por su complejidad y volumen, tampoco podríamos sacar partido. Algo similar sucede en la economía y las finanzas, en el comercio electrónico o en el transporte, por citar otras áreas. Básicamente, cualquier aplicación que se beneficie del análisis de grandes cantidades de datos no estructurados es susceptible de ser transformada por la IA.

La capacidad de actualizar el software de manera masiva es también una propiedad clave. Combinada con la escalabilidad, la actualización

masiva permite a la IA tener impacto en la vida de cientos o incluso miles de millones de personas en poco tiempo.

Otra propiedad definitoria de la IA es su habilidad para predecir. Los sistemas de Inteligencia Artificial pueden utilizarse para la toma de decisiones automáticas y para predecir situaciones futuras. De hecho, aspiramos a que las decisiones algorítmicas basadas en IA entrenada con datos carezcan de las limitaciones de las decisiones humanas -- conflictos de interés, sesgos, intereses propios, corrupción...--, y sean por tanto más justas y objetivas.

Sin embargo, esto no será necesariamente así si ignoramos las limitaciones de las decisiones que toman los algoritmos, como explicaré posteriormente.

Ni ciencia ficción, ni moda

La presencia de la IA en nuestras vidas, y su capacidad para mejorar la sociedad, son innegables. Las grandes potencias mundiales --tanto empresas como gobiernos-- han comprendido que el liderazgo en Inteligencia Artificial debe ser no solo económico, sino también político y social.

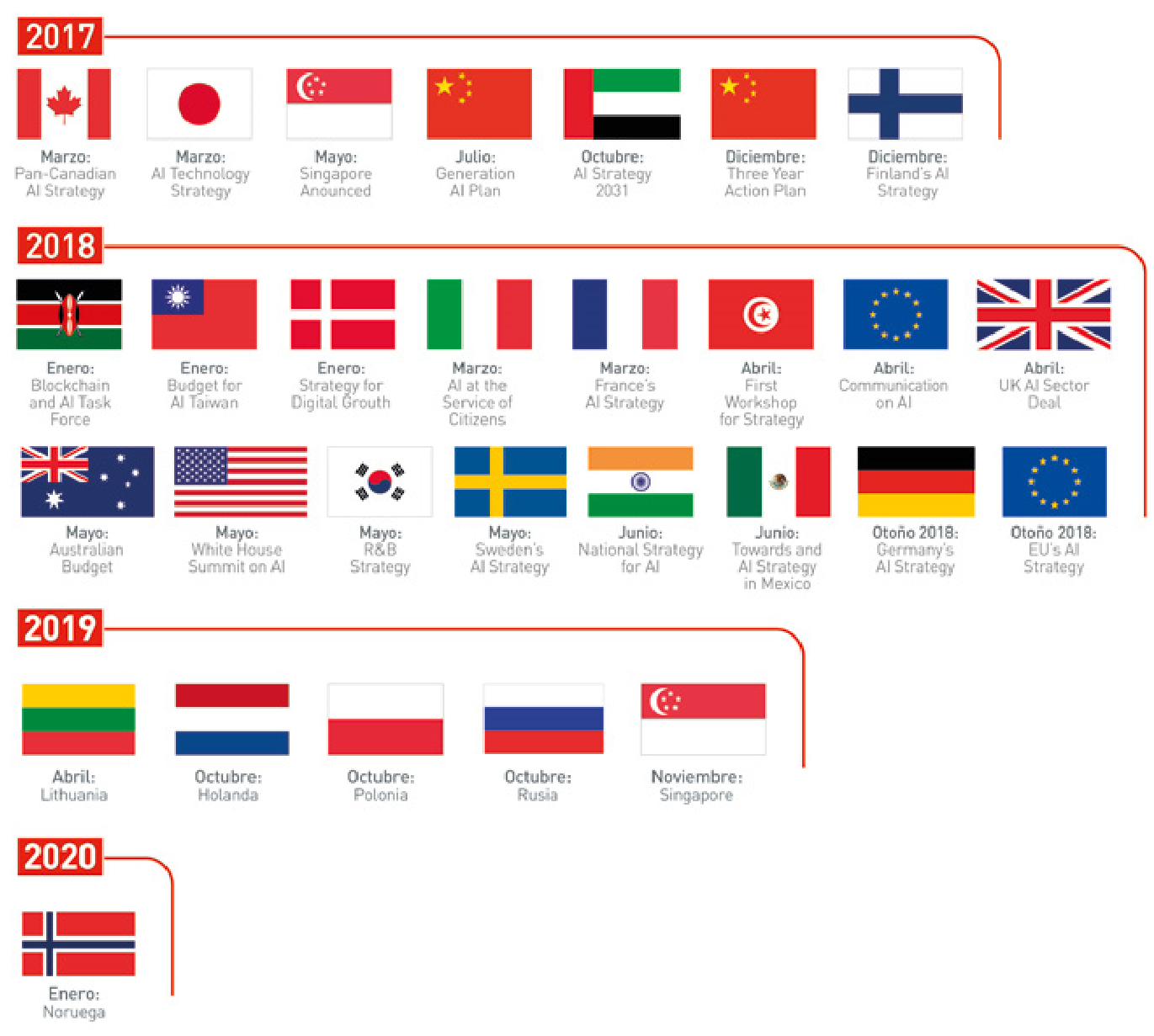

Por eso en los últimos dos años los gobiernos de más de una veintena de países --incluyendo EE. UU., China, Canadá, Francia, Taiwán, Singapur, México, Suecia, India, Australia y Finlandia-- han elaborado estrategias nacionales sobre Inteligencia Artificial, tal y como refleja la Figura 14.

En Europa, el grupo de expertos sobre IA creado por la Comisión Europea --del que soy miembro reserva-- publicó en 2019 un conjunto de guías éticas para la Inteligencia Artificial y unas recomendaciones sobre inversiones y políticas en IA. Esta estrategia europea propone actuaciones conjuntas para una cooperación más estrecha y eficiente entre los Estados miembros, Noruega, Suiza y la Comisión en cuatro ámbitos clave: aumentar la inversión, lograr que haya más datos disponibles (para entrenar a los algoritmos de IA), fomentar

el talento y garantizar la confianza. En febrero de 2020, la Comisión Europea publicó un Libro Blanco sobre Inteligencia Artificial[31], que sentó las bases para la regulación. Posteriormente, en abril de 2021, la Comisión propuso el Reglamento de Inteligencia Artificial (AI Act)[32], la primera normativa integral sobre IA a nivel mundial, que fue finalmente adoptado por el Parlamento Europeo en marzo de 2024 y entró en vigor el 1 de agosto de 2024[33], estableciendo un marco regulatorio basado en riesgos para aplicaciones de IA, especialmente aquellas con impacto en la vida de las personas, como la salud o el transporte.

El entonces vicepresidente de la Comisión, el estonio Andrus Ansip, afirmaba en una nota de prensa: "Hemos acordado colaborar a fin de reunir datos --la materia prima de la Inteligencia Artificial-- en sectores como la asistencia sanitaria para mejorar el diagnóstico y el tratamiento del cáncer. Tendremos que actuar coordinadamente para lograr el objetivo de inversiones públicas y privadas de al menos 20.000 millones de euros, algo fundamental para el crecimiento y el empleo. La Inteligencia Artificial no es un capricho, es nuestro futuro".

Esta inversión anual en I+D dedicada a la IA de 20.000 millones de euros anuales en el periodo 2021-2027 es necesaria para reducir la brecha entre la inversión en IA de Europa --de entre 3.000 y 15.000 millones de euros--, y la de Asia y Norteamérica. La Comisión propone un reparto de esfuerzos de inversión entre diferentes actores europeos para conseguir alcanzar la inversión mencionada: 1.000 millones al año serían a cargo de programas de I+D (Horizon Europe y Europa Digital); los Estados miembros invertirían 6.000 millones anuales, parte de los cuales podría proceder de fondos europeos; y 13.000 millones de euros deberían proceder del sector privado.

En febrero de 2020, la Comisión Europea publicó tres documentos estratégicos en el contexto de la Inteligencia Artificial.

En primer lugar, un libro blanco[34] sobre Inteligencia Artificial donde la Comisión Europea presenta un marco para el desarrollo de una Inteligencia Artificial confiable, basada en la excelencia y la confianza. Este documento propone la definición de reglas claras en aplicaciones de alto riesgo de la Inteligencia Artificial, incluyendo la salud, el transporte o la policía. El objetivo es garantizar que los sistemas de IA son transparentes, supervisados por humanos y susceptibles de ser evaluados y certificados por autoridades externas. También se incluye la necesidad de asegurar que los datos con los que se entrenan estos sistemas no tienen sesgos y que siempre se respetan los derechos fundamentales. En el caso de aplicaciones de la IA de bajo riesgo, la Comisión Europea propone un esquema de etiquetado voluntario.

En segundo lugar, la Estrategia de Datos[35] aspira a crear un único mercado europeo para datos que asegure la competitividad de Europa y la soberanía de sus datos.

En tercer lugar, un documento con recomendaciones por parte del grupo de alto nivel de "Business to Government Data Sharing"[36] , que incluye la adopción de medidas legislativas sobre la gobernanza de los datos, el acceso y su reutilización para el interés público.

En cuanto a los Estados miembros, numerosos países han publicado sus estrategias nacionales de IA acompañadas de ambiciosos compromisos presupuestarios: Alemania estableció en 2018 una estrategia dotada con 3.000 millones de euros hasta 2025, ampliada en 2020 con 2.000 millones adicionales hasta alcanzar un total acumulado de 5.000 millones para el periodo 2018-2025[37], habiendo ejecutado 3.380 millones hasta 2024; Francia implementó su estrategia en tres fases con inversión pública progresiva (1.500 millones en 2018-2022, 560 millones en 2022-2025, y 2.500 millones desde 2025), y además consiguió atraer 109.000 millones de euros en compromisos de inversión privada anunciados en la Cumbre de IA de París de febrero de 2025[38]; Finlandia comprometió 100 millones anuales a partir de 2019; y España, tras su primera Estrategia Nacional de IA de 2020 con 600 millones para 2021-2023, aprobó en mayo de 2024 una Estrategia actualizada con 1.500 millones adicionales para 2024-2025[39], sumando un total de 2.100 millones entre 2021-2025, financiados principalmente por el Plan de Recuperación europeo.

Además, algunos Gobiernos, como el británico, han creado sus propias organizaciones de Inteligencia Artificial (Office of AI, Office of Ethics in AI), con carácter transversal, para maximizar el impacto de la IA y acelerar su desarrollo y adopción.

La OCDE probó en mayo de 2019 una Recomendación sobre Inteligencia Artificial [40] a la que se han adherido 36 países miembros y seis países no miembros.

En España se creó un comité de nueve expertos multidisciplinares en 2017, para la elaboración de un libro blanco sobre el Big Data y la IA con recomendaciones estratégicas. Tras la publicación de una estrategia de I+D+i en IA en junio de 2019, el presidente Pedro Sánchez presentó en diciembre de 2020 la primera Estrategia Nacional de Inteligencia Artificial con una inversión de 600 millones de euros para el periodo 2021-2023[41]. Posteriormente, en mayo de 2024, el Gobierno aprobó una Estrategia actualizada[39:1] que añade 1.500 millones de euros adicionales para 2024-2025, sumando un total de 2.100 millones entre 2021-2025, financiados principalmente por el Plan de Recuperación, Transformación y Resiliencia europeo. La estrategia actualizada incluye inversiones significativas en supercomputación (90 millones de euros para el superordenador MareNostrum), desarrollo de talento (760 millones de euros en áreas de investigación y formación especializada), y apoyo al sector privado (400 millones de euros a través del Fondo NextTech y 350 millones en el programa Kit Digital).

Curiosamente, dos comunidades autónomas han asumido cierto liderazgo en IA y han publicado sus estrategias: Cataluña y la Comunidad Valenciana[42].