Los retos de la IA

Aprovechar la IA exige conocer sus limitaciones

La Inteligencia Artificial ayudará sin duda a hacer frente a los grandes problemas del siglo XXI. Pero, como todas las herramientas poderosas, su uso requiere sabiduría. ¿Cómo adquirirla? Más aún, ¿cómo lograr que todos la adquiramos? Por paradójico que parezca, ser actor de pleno derecho en la era de las máquinas inteligentes exige potenciar habilidades exclusivamente humanas, como la creatividad. También, entrenar la capacidad de resistir a adictivos cantos de sirena que llegan en forma de notificaciones o likes. ¡Ah! Y recuperar esa exótica sensación, hoy casi olvidada, de estar aburridos.

Entramos en el siglo XXI enfrentándonos a no pocos desafíos. Nuestro éxito como especie ha traído consigo una población cada vez más envejecida, el cambio o, mejor dicho, la crisis climática y una acuciante pérdida de biodiversidad a escala planetaria, entre otros grandes retos.

En este contexto, el potencial de la Inteligencia Artificial para ayudarnos a buscar soluciones es inmenso. Sin embargo, los sistemas actuales de IA presentan limitaciones que tendremos que abordar.

Algunos de estos puntos débiles derivan de rasgos distintivos de la Inteligencia Artificial, más allá de los que ya conocemos: transversalidad, invisibilidad, complejidad, escalabilidad, actualización constante y capacidad para predecir. Pero debemos considerar otras características adicionales.

Una es la asimetría. Hoy día los sistemas de Inteligencia Artificial deben ser diseñados y entrenados por personas expertas, y necesitan acceder a grandes cantidades de datos y de computación. Se da, desgraciadamente, una situación de asimetría porque solo una minoría que tiene acceso a datos, capacidad de computación, conocimiento y experiencia puede beneficiarse plenamente de la Inteligencia Artificial. En cambio, la mayoría de la población, incluyendo administraciones públicas, ONGs o pequeñas y medianas empresas, carece de estas capacidades y es, en el mejor de los casos, mera usuaria de la tecnología. No es baladí el detalle de que a la minoría privilegiada pertenecen las grandes empresas tecnológicas que poseen, de hecho, gran parte de los datos.

Minimizar esta asimetría es uno de los grandes desafíos al que nos enfrentamos si queremos garantizar que la Inteligencia Artificial tenga un impacto positivo en toda la sociedad y no solo en una pequeña parte.

Otro gran reto deriva de la capacidad de los sistemas de IA para crear contenidos ficticios que podrían pasar por auténticos. El poder de la IA para generar fotos, textos, audios y vídeos indistinguibles del contenido real –lo que llamamos contenido sintético o deep fakes, por estar generados utilizando redes neuronales profundas– está transformando la comunicación, la difusión de la información y la formación de la opinión pública. Controlar la producción y distribución de este contenido artificial equivale a poseer un poder sin precedentes 1.

Además, los sistemas de IA no son invulnerables ante un uso malicioso de los mismos o ante su hackeo. De hecho, un área nueva dentro de la IA es la llamada aprendizaje adversarial, donde se entrenan sistemas de IA que engañen a otros sistemas de IA. Cuantas más decisiones de nuestra vida estén parcial o totalmente delegadas a sistemas de IA, dichos sistemas no van a ser hackeados.

Si no abordamos estos desafíos, el impacto de la IA no estará necesariamente distribuido de manera homogénea o justa en la sociedad. En este capítulo y en el siguiente describiré brevemente cuatro dimensiones fundamentales que hemos de considerar en el contexto del desarrollo de la IA: su impacto económico; la necesidad de invertir en el desarrollo de capacidades; el valor de la diversidad; y la importancia de definir un marco ético y una nueva gobernanza de los sistemas de IA.

Economía: viento en las velas

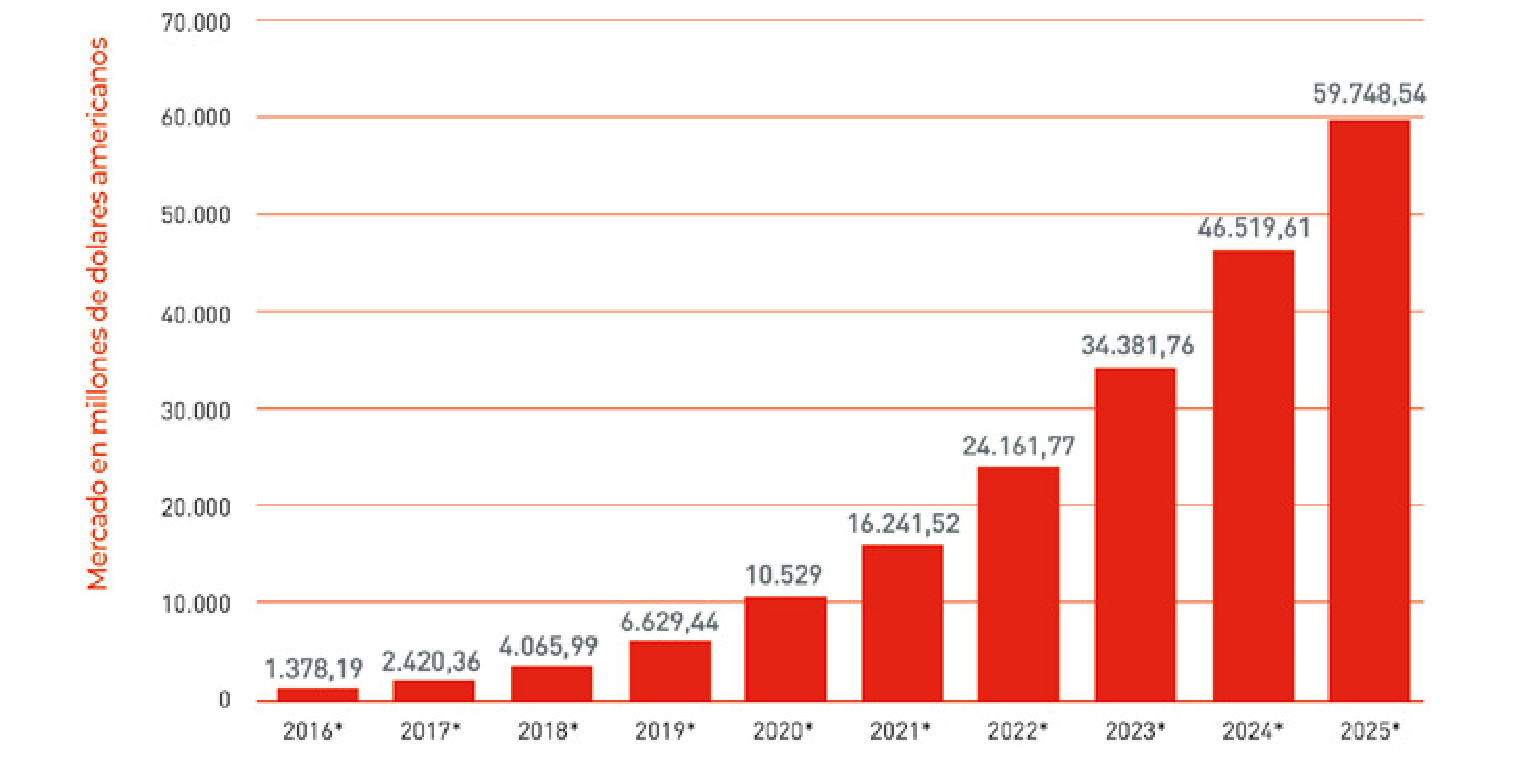

Desde un punto de vista económico, en 2020 el mercado de productos, hardware y software, relacionados con la Inteligencia Artificial se espera que supere los 10.000 millones de dólares, según un estudio de Statista (ver Figura 15). Con un crecimiento sostenido en el tiempo, un análisis macroeconómico de PwC estima que la Inteligencia Artificial generará en el año 2030 más de 15 billones –millones de millones– de dólares a escala mundial. Su efecto se hará sentir en todos los ámbitos de actividad y tanto en el sector público como en el privado.

Aplicada a los procesos de automatización, y como apoyo a la fuerza laboral, la Inteligencia Artificial impulsará la productividad, y de ahí su gran impacto económico. Además, habrá una demanda creciente de productos y servicios enriquecidos con IA por parte de los consumidores.

Norteamérica y China experimentarán los mayores beneficios, dada la concentración de la investigación, la innovación y el desarrollo de la Inteligencia Artificial en estas regiones.

Fig. 15 Estimación del tamaño del Mercado global de la Inteligencia Artificial en millones de dólares americanos (fuente: Statista).

Con respecto a la innovación en IA, un estudio reciente de Asgard y Roland Berger analiza la distribución de jóvenes empresas del sector en todo el planeta. EE.UU. es el líder mundial, con un 40% de todas las empresas emergentes de IA analizadas –alrededor de 1.400 start-ups, de las cuales unas 600 están en San Francisco–, seguido de China e Israel. En Europa, Londres es la segunda ciudad del mundo en número de empresas de IA, seguida de París en décima posición.

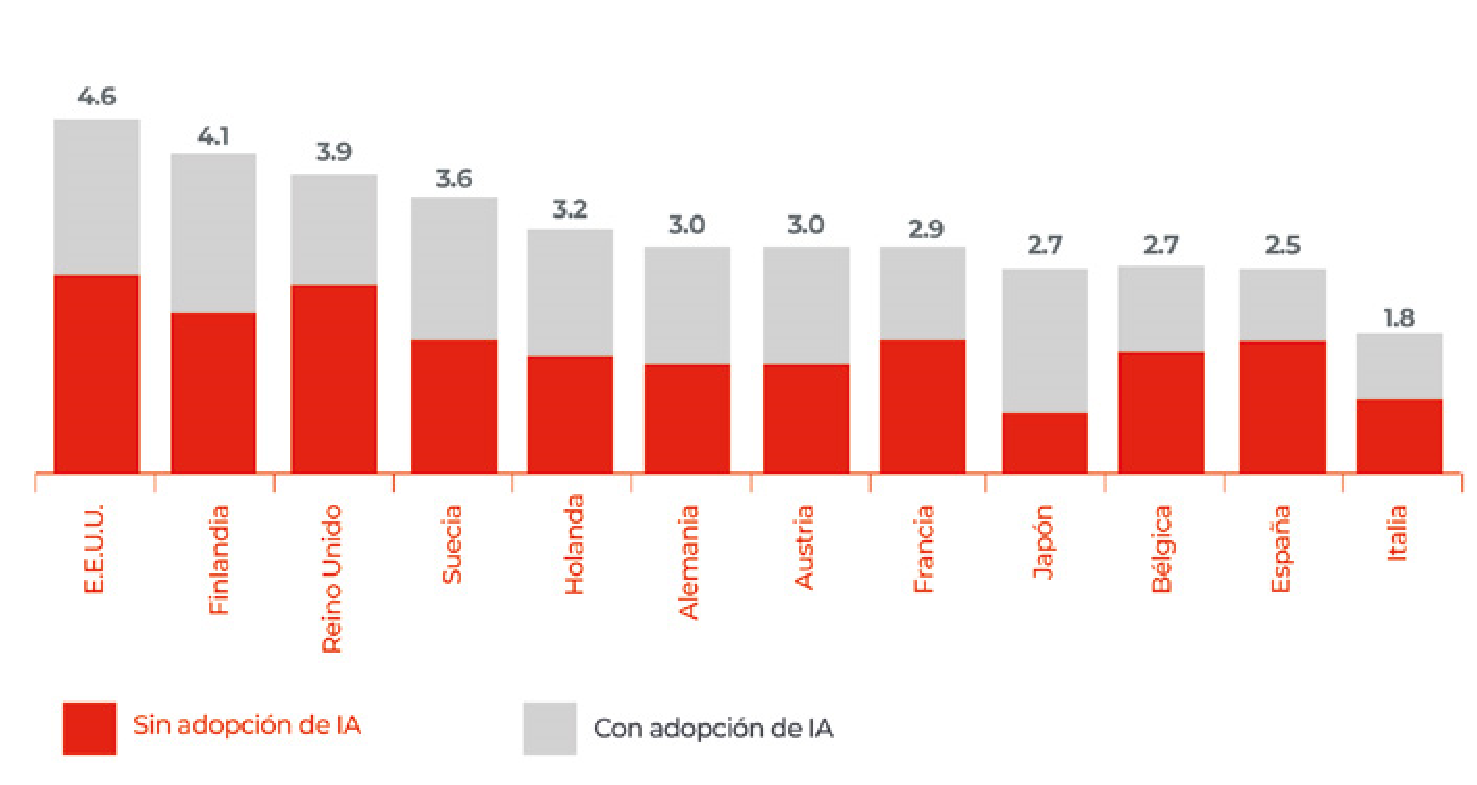

Otro informe, de Accenture y Frontier Economics, estima el crecimiento económico que diferentes países podrían tener si invirtiesen en IA y consiguiesen incorporar sus beneficios a la economía –en comparación con el crecimiento económico de base, sin la aportación de la Inteligencia Artificial–. El modelo descrito en este informe estima que la Inteligencia Artificial tiene el potencial de duplicar las tasas de crecimiento de los 12 países estudiados, entre los que se encuentran EE. UU., Finlandia, Reino Unido, Alemania, Francia y España.

La Inteligencia Artificial nos permitirá disponer de una medicina de precisión personalizada, preventiva y predictiva; una educación a medida de cada uno, y permanente; ciudades inteligentes; una gestión más eficiente de los recursos; y una toma de decisiones más justa, transparente y basada en la evidencia. Pero las nuevas herramientas vendrán acompañadas de cambios sociales profundos fruto de la Cuarta Revolución Industrial anteriormente descrita, incluyendo una transformación radical del mercado laboral y de las capacidades relevantes para el siglo XXI.

Fig. 16 Estimación del crecimiento del Producto Interior Bruto (PIB) de diferentes economías mundiales (incluyendo la española), en función de su capacidad para adoptar o no la IA (fuente: Accenture y Frontier Economics).

LA ECONOMÍA INTELIGENTE EN ESPAÑA

La economía española podría verse muy beneficiada del uso de sistemas de Inteligencia Artificial en multitud de sectores, entre ellos muchos de valor estructural como salud; el transporte; la energía; la agricultura; el turismo; el comercio electrónico; la banca; y la administración pública. Un estudio de Accenture y Frontier Economics 2 prevé que en 2035 el 0,8% del crecimiento del PIB español podrá atribuirse a la IA, un efecto que debería traducirse en más enriquecimiento para la sociedad en su conjunto.

El mercado laboral sufrirá una transformación profunda. En España, la Organización para la Cooperación y el Desarrollo Económico (OCDE) cifra en un 12% los empleos susceptibles de perderse por la automatización. Pero no hay que olvidar que el desarrollo de tecnologías disruptivas con capacidad para transformar la sociedad ha conllevado históricamente la generación de empleo 3.

El informe EPYCE 2018 4 recoge que el perfil más demandado en España actualmente es el de Científico/a de Datos, seguido de perfiles relacionados con el Big Data e ingeniero/a informático. La tendencia para el futuro, según el mismo estudio, no es muy distinta: el 57% de las profesiones más demandadas en España se enmarcarán en los ámbitos de la ingeniería y la tecnología.

Habría que asegurarse de que los trabajadores/as -hoy en día y en las décadas venideras- cuentan con la preparación necesaria para aprovechar las nuevas oportunidades.

Si lo puede hacer una máquina, lo hará (sola o con nuestra colaboración)

El progreso tecnológico asociado a la Cuarta Revolución Industrial está polarizando el mercado laboral. Mientras aparecen nuevos trabajos bien remunerados y que requieren especialización en áreas tecnológicas, como científico/a de datos, otras profesiones se enfrentan a la automatización parcial o total: taxistas y transportistas, cajeros/as y agentes de viaje, entre muchos otros. Si una tarea puede ser automatizada, lo será, total o parcialmente. Si la tecnología puede aumentar la eficiencia de un proceso, será necesario un menor número de trabajadores humanos para llevarlo a cabo.

En consecuencia, la demanda laboral está experimentando un sesgo en beneficio de habilidades profesionales especializadas, y en perjuicio de ocupaciones rutinarias y mecánicas. Esta tendencia permite pronosticar un cambio completo en la estructura ocupacional, una transformación que probablemente conlleve riesgos para la sociedad si no nos adaptarnos.

Según un estudio de McKinsey, un tercio de los nuevos puestos de trabajo creados en EE. UU. en los últimos 25 años pertenecen a disciplinas que no existían anteriormente, en áreas como las tecnologías de la información, la fabricación de hardware, la creación de aplicaciones móviles o la gestión de sistemas tecnológicos.

En la próxima década el empleo se concentrará en funciones cualificadas y con mayor aportación de valor, llegando a tasas de paro inferiores al 3,5% para estos perfiles, frente a un 20% para profesiones de una baja cualificación. Estos datos no implican necesariamente un aumento del desempleo. A escala global, un estudio reciente del Foro Económico Mundial 5 prevé un crecimiento neto de 58 millones de puestos de trabajo en 2022 como efecto de la IA. Es decir, se espera la desaparición de 75 millones de puestos de trabajo, sí, pero también la creación de 133 millones.

La Comisión Europea 6, por su parte, anticipa que hará falta cubrir entre 700.000 y 900.000 nuevos puestos de trabajo tecnológicos a corto plazo.

La clave es que estas nuevas oportunidades laborales serán de naturaleza muy distinta a los puestos que se verán desplazados por la IA. Por ello, ¿estamos preparados, como sociedad, para suplir la demanda de nuevas ocupaciones derivadas de la IA?

Considero que no. Si no transformamos nuestros programas educativos, no lo lograremos. Es de vital importancia que invirtamos en la formación de profesionales cuyo trabajo va a verse afectado por el desarrollo de la Inteligencia Artificial, de manera que puedan seguir contribuyendo a la sociedad.

En continuo aprendizaje

Estamos progresando hacia un modelo de aprendizaje continuo a lo largo de la vida, un modelo en el que cada persona actualiza y diversifica su carrera profesional de manera permanente.

Gracias a la tecnología disponemos de sistemas de formación continua como los llamados cursos masivos en línea –MOOC en sus siglas en inglés–, que ofrecen, de manera escalable y económica, oportunidades de aprendizaje a cualquier persona desde cualquier lugar. Deberíamos asegurarnos de que los profesionales pueden aprender tecnologías emergentes en sus ámbitos de actividad, y así continuar cumpliendo una función incluso –y especialmente– si sus áreas de competencia se ven afectadas por la automatización.

Esta necesidad de aprendizaje constante, consecuencia del cambio también incesante causado por el progreso tecnológico, puede ser difícil de gestionar desde un punto de vista emocional. Como bien sabemos, los humanos solemos ser resistentes al cambio, especialmente conforme envejecemos. Deberíamos por tanto contemplar la posibilidad de que algún colectivo sea incapaz de adaptarse a la permanente necesidad de aprendizaje, lo que lo privaría de las herramientas necesarias para contribuir a la sociedad del mañana.

Corremos el riesgo de que este grupo social se convierta, en palabras del historiador Yuval Noah Harari, en una “clase inútil” 7. ¿Cómo tratar el problema? Algunas soluciones propuestas son la creación de un salario básico universal o la provisión universal y gratuita de las necesidades básicas por parte de los gobiernos.

Más allá del mercado laboral, el desarrollo e implantación de una Inteligencia Artificial centrada en las personas debería resultar en un empoderamiento de la ciudadanía, de cada uno de nosotros. Una condición necesaria para este empoderamiento es el conocimiento.

La asignatura pendiente: el ‘Pensamiento Computacional’

Necesitamos invertir en educación formal e informal. De lo contrario será muy difícil, si no imposible, que como sociedad seamos capaces de tomar decisiones sobre tecnologías que no entendemos, y que en consecuencia frecuentemente tememos. Coincido plenamente con las palabras de Marie Curie, “nada en la vida debería temerse, sino entenderse. Ahora es momento de entender más para así temer menos”. Pero ¿dónde estamos? ¿Qué nivel de conocimiento tecnológico tenemos, tanto niños y jóvenes como adultos?

En el libro Los nativos digitales no existen 8 exploro estas preguntas en el capítulo Erudit@s digitales, que enfatiza la necesidad de enseñar Pensamiento Computacional en la educación obligatoria, así como de desarrollar el pensamiento crítico, la creatividad y la inteligencia social y emocional. Son habilidades que hoy descuidamos, y sin embargo cada vez van a resultar más importantes para nuestra salud mental y nuestra coexistencia pacífica y armoniosa con la tecnología, con otros humanos y con nuestro planeta.

El término alfabeto digital se refiere a quienes saben utilizar una amplia gama de dispositivos digitales, como teléfonos móviles, ordenadores, tabletas, etc. Desde este punto de vista podríamos considerar que la gran mayoría de nuestros jóvenes, adolescentes y niños son hoy día alfabetos digitales. Según un estudio reciente de Pew Research Center sobre el uso de la tecnología en los adolescentes estadounidenses, un 88% de ellos tienen un teléfono móvil, un 94% tienen acceso a un ordenador y un 24% reconocen estar conectados casi constantemente.

Este nivel de adopción de la tecnología es sin duda una buena noticia, ya que numerosos estudios corroboran el impacto positivo del acceso a la tecnología e internet en el desarrollo de un país. Así pues, observando estas cifras podríamos pensar que las nuevas generaciones están plenamente preparadas para ser competentes en el mundo digital. Después de todo, son nativos digitales. ¿O tal vez no?

Es fundamental no confundir el saber usar una tecnología con saber cómo funciona. Y aunque nuestros hijos vivan enganchados a ella, tanto chicos como chicas, ¿cuántos de ellos saben cómo funciona esa tecnología alrededor de la cual gira su vida?

Parecería que muy pocos. Un estudio de Horizon 2014 en Europa enfatiza los deficientes niveles de competencia digital de los niños y adolescentes europeos. Otro informe reciente, de EU Kids Online9, subraya que dos tercios de los niños británicos de entre 9 y 10 años saben sobre internet tanto como sus progenitores. En lo que se refiere al conocimiento de la tecnología en la ciudadanía, también queda todavía mucho camino por recorrer. Una encuesta reciente de la Fundación Española de la Ciencia y la Tecnología (FECYT)10 arroja resultados preocupantes: sólo un 16.3% de los españoles sienten interés por la tecnología o la ciencia, un porcentaje que desciende al 13.7% cuando se considera únicamente a las mujeres.

En vista de estos resultados, la Comisión Europea publicó en 2018 un Plan de acción de la educación digital, que incluye once acciones para fomentar el uso de la tecnología y el desarrollo de competencias tecnológicas a través de la educación. El Plan señala tres prioridades: hacer un mejor uso de la tecnología digital para la enseñanza y el aprendizaje; desarrollar competencias y habilidades digitales de relevancia para la transformación digital; y mejorar los sistemas educativos a través del análisis de datos y procesos de previsión.

Desde un punto de vista formal, la educación obligatoria de muchos países del mundo –entre los que desgraciadamente no se encuentra España– ya incorpora en todas o algunas de sus etapas una asignatura troncal de Pensamiento Computacional. El concepto Pensamiento Computacional 11 hace referencia a los procesos mentales –humanos– que ayudan a formular los problemas de manera que un ordenador pueda operar con ellos y resolverlos. Algo así como aprender a pensar como una máquina para poder utilizarla en la resolución de problemas, y de este modo conseguir que todos podamos beneficiarnos de la capacidad de los ordenadores para buscar soluciones óptimas.

No es una idea nueva. El término fue empleado por primera vez por Seymour Papert en su libro de 1980 titulado Desafío a la mente: computadoras y educación. Seymour era en aquel momento codirector con Marvin Minsky del laboratorio de Inteligencia Artificial de MIT y fue pionero del uso de los ordenadores en el aprendizaje de los niños. Creó, entre otros, el lenguaje de programación Logo con fines educativos.

Más recientemente, en 2006, Jeanette Wing –en ese momento en la Universidad de Carnegie Mellon– escribió un artículo 12 para la publicación de la Asociación de Maquinaria de Computación, Communications of the ACM, que dio visibilidad a la importancia del Pensamiento Computacional como una habilidad y una actitud valiosa para todas las personas, no solo para los expertos/as en informática. Para Wing, “el Pensamiento Computacional describe la actividad mental orientada a formular un problema de manera que admita una solución computacional. Esta solución puede ser llevada a cabo por humanos o por máquinas, o por una combinación de humanos y máquinas”.

Como asignatura, el Pensamiento Computacional abarca cinco áreas de conocimiento básicas en un contexto tecnológico, adaptadas a cada nivel educativo: los algoritmos, los datos, las redes, la programación y el hardware. Existen ejemplos de currículos de Pensamiento Computacional de distintos países del mundo, que pueden tomarse como referencia [29, 33, 34]. Uno de los esfuerzos de mayor envergadura es probablemente el de Reino Unido, que incorpora un currículum de Pensamiento Computacional en todos los colegios a partir de los cinco años. Además, hay programas específicos para atraer a las niñas a las ciencias y la tecnología. Es destacable igualmente la iniciativa lanzada en 2016 en EE. UU. por el entonces presidente Barack Obama, dotada con de 4.000 millones de dólares, para universalizar el estudio de la informática y las competencias digitales en los colegios del país.

Uno de los mayores retos con respecto al éxito en la incorporación del Pensamiento Computacional en la educación obligatoria es la inversión ambiciosa en la necesaria formación al profesorado. En España existe un proyecto de ley educativa que incorpora el Pensamiento Computacional. Ojalá cuando estén leyendo este libro ya esté aprobada dicha ley. Porque los sistemas educativos de otros países ya enseñan, entre otras cosas, a programar y a diseñar algoritmos, y a representar y analizar datos en los ordenadores.

Los niños y niñas de esos países serán conscientes del valor de sus datos personales, entenderán cómo se comunican las máquinas entre sí y cómo funcionan el World Wide Web, los buscadores y las redes sociales. A esos niños y a esas niñas se les están brindando oportunidades para desarrollar sus competencias digitales. ¿Y a los nuestros?

Corremos el riesgo de que haya una élite minoritaria –y homogénea– de expertos que saben cómo funciona la tecnología y son capaces de crearla, erigiéndose así en constructores exclusivos de un futuro a su medida. Mientras tanto, una gran masa de gente usará esa tecnología que otros han creado y quedará excluida –excepto como consumidores– de ese futuro tecnológico.

Es importante destacar que la inacción no va a resolver la situación. Deberíamos poder ofrecer a nuestros niños la educación que les permita llegar a ser erudit@s digitales (vease el recuadro “erudit@s digitales” en la página 90). Y deberíamos también poner en marcha acciones para fomentar vocaciones científico–tecnológicas entre nuestros jóvenes –dada la inmensa demanda anticipada en profesiones tecnológicas–, especialmente entre las chicas, ya que en el ámbito tecnológico hay una preocupante falta de diversidad de género. Como veremos a continuación, la diversidad enriquece, tanto literal como metafóricamente.

El mundo necesita más erudit@s digitales, formarlos está en nuestras manos, como explico a continuación.

ERUDIT@S DIGITALES

Una persona erudita digital entiende la diferencia entre, por ejemplo, llamar vía Skype y por teléfono tradicional; sabe qué son y cómo se usan sus datos personales capturados online; conoce el término Big Data, y el valor de las cantidades ingentes de datos; está familiarizada con el funcionamiento de internet, una red social o un móvil/ordenador; y sabe programar, entre otras habilidades.

Ser erudito digital comporta poder apoyarse en la tecnología para desarrollar el propio potencial, y contribuir a desarrollar el potencial de la tecnología como herramienta para fomentar la creatividad, resolver problemas, crear oportunidades y, en general, mejorar la calidad de vida.

Ser erudito digital implica saber cómo distinguir entre el contenido veraz y el no veraz, poder contrastar contenidos digitales y crear nuevos contenidos propios.

Sin embargo, además de las capacidades técnicas será fundamental desarrollar la creatividad y los aspectos emocionales y sociales de nuestra inteligencia. Serán estas habilidades las que nos ayudarán a sacar el máximo partido de una tecnología que cada vez va a ser más potente –incluso superará nuestras habilidades–, y al mismo tiempo más adictiva.

Por ello, ser erudito digital requiere también desarrollar capacidad de autocontrol y sentido crítico. Son estas habilidades las que sirven de guía a la hora de discernir entre el uso apropiado y el no apropiado de la tecnología, entre el uso productivo, constructivo, y el que no es ni productivo ni constructivo.

Los nativos digitales no nacen, se hacen: hacia una sociedad de erudit@s digitales

Las habilidades y los conocimientos necesarios para los jóvenes de hoy deben ser enseñados, no se aprenden simplemente usando la tecnología. Es una de las conclusiones del Estudio Internacional en Alfabetización sobre la Información y la Informática, publicado en 2013 y que analiza el grado de competencia con los ordenadores y la capacidad para gestionar información de 60.000 alumnos de 2ª de la ESO en 21 sistemas educativos en todo el mundo.

Los estudiantes, revela el trabajo, no adquieren las capacidades digitales necesarias si estas no son enseñadas formalmente. En otras palabras, para contribuir realmente a la sociedad del futuro no basta con ser usuario de la tecnología. Ese es obviamente un primer paso para poder orientarse –¿sobrevivir? – en un mundo altamente automatizado; pero si de verdad queremos que las próximas generaciones contribuyan a este futuro tecnológico tenemos que asegurarnos de que adquieren las capacidades para ser erudit@s digitales.

Para conseguir que nuestros jóvenes participen en el diseño del mundo que viene deberíamos enseñarles cómo funciona la tecnología, y además ayudarles a desarrollar un sentido crítico en su uso. Una cosa es usar y consumir, y otra muy distinta conocer.

Por ello propongo que dediquemos esfuerzos para fomentar una cultura de erudit@s digitales. El concepto de erudición digital conlleva dimensiones tanto de conocimiento técnico de la tecnología, como de desarrollo de la creatividad, el pensamiento crítico y de herramientas emocionales y sociales para tomar decisiones, colaborar y contribuir en la sociedad del futuro.

Desde un punto de vista de los conocimientos técnicos, ser erudito digital implica conocer con detalle cómo funciona la tecnología que usamos en nuestro día a día, para poder crear a su vez nuevas herramientas que contribuyan al progreso y nos ayude a afrontar los retos globales. La solución a problemas tan poco triviales como el calentamiento global, la crisis energética, el envejecimiento de la población o la brecha entre ricos y pobres tendrá en muchos casos un fuerte componente tecnológico, y de tecnología que aún no hemos inventado.

Ser erudit@ digital implica dominar el Pensamiento Computacional –como hemos descrito anteriormente, pero no únicamente–. La empatía, la paciencia, la perseverancia, la concentración mantenida en una tarea compleja, la tolerancia, la flexibilidad, la habilidad de gestionar el aburrimiento o de aceptar una gratificación a largo plazo son igualmente cualidades muy valiosas en el contexto actual.

Son, también, cualidades que difícilmente podemos desarrollar y cultivar con experiencias exclusivamente tecnológicas, diseñadas para gratificarnos inmediatamente y con frecuentes interrupciones. Veamos algunas de ellas en más detalle.

Golosinas para el cerebro

La gratificación a largo plazo se asocia con la capacidad de rechazar un premio inmediato pero pequeño, a cambio de conseguir otro mayor, más tarde. En la literatura científica se han encontrado conexiones entre la capacidad para la gratificación a largo plazo y el éxito académico, la salud física y psicológica, y las habilidades sociales. La gratificación a largo plazo está asociada con la paciencia, el control de los impulsos, la fuerza de voluntad y el autocontrol, habilidades que forman parte de la función de autorregulación de las personas.

Según numerosos trabajos 13, la gratificación a largo plazo es una habilidad con impacto positivo en nuestra vida, uno de los elementos que nos permite perseverar en tareas que no dan sus

frutos de inmediato. ¿Pero qué relación tiene la tecnología con la gratificación a largo plazo?

La tecnología de hoy en día, con una cantidad ilimitada de estímulos altamente atractivos para nuestras neuronas, es como una golosina para nuestro cerebro. Además, suele enfocarnos en el momento presente, el ahora, lo que aumenta nuestra susceptibilidad a la gratificación a corto plazo y nos hace más difícil pensar a largo plazo.

Según el profesor emérito de psicología de la Universidad de Stanford, Philip Zimbardo, autor del libro La paradoja del tiempo: La nueva psicología del tiempo, la tecnología está impactando nuestra percepción del tiempo y nuestra manera de pensar. “La tecnología crea una obsesión con el tiempo, pero está muy enfocada en el corto plazo, en el momento presente”, ha afirmado Zimbardo.

Desde un punto de vista psicológico lo ideal es encontrar un equilibrio entre tres horizontes temporales. Es importante mirar al futuro, porque eso nos motiva a perseverar en la obtención de objetivos a medio-largo plazo; también lo es mantener una perspectiva positiva del pasado, de manera que cuando reflexionemos sobre nuestra vida y hechos pasados tengamos una sensación placentera; y, finalmente, hay que incorporar una vivencia hedonista del presente, para poder disfrutar del momento, de los amigos y familiares.

Cada vez tenemos una relación más íntima e intensa con la tecnología, mirando constantemente nuestros dispositivos móviles, enviando y recibiendo mensajes, conectándonos a través de redes sociales y siendo interrumpidos por notificaciones cada vez más abundantes.

Según la consultora Nielsen, el 43% del tiempo que dedicamos a interaccionar con tecnología lo dedicamos a actividades de entretenimiento y auto-estimulación. En la misma línea, en 2017 un estudio de Activate cuantificaba en más de 12 horas diarias el tiempo que los adultos estadounidenses dedicaban al consumo de tecnología para el entretenimiento y las relaciones sociales, incluyendo los periodos de multitarea, es decir mientras hacen otras cosas 14.

Esta omnipresencia de la tecnología nos somete a un estado de presente hedonista. Con nuestra atención secuestrada, permanecemos concentrados mayoritariamente –y a veces exclusivamente- en el ahora, lo que dificulta nuestra capacidad para encontrar el necesario equilibrio con las otras dos perspectivas temporales fundamentales en nuestra vida: el medio-largo plazo, y el pasado.

Un estudio del Instituto Pew en 2012 encontró que entre la generación conocida como millennials la hiperconectividad podría contribuir a una necesidad de gratificación inmediata, y a una falta de paciencia. El estado de conexión permanente nos proporciona estímulos de manera casi inmediata, acelerando nuestro sentido del tiempo y fomentando la impaciencia cuando algo tarda más de unos segundos en suceder.

Otro elemento que fomenta nuestro foco en el ahora y en la gratificación inmediata es la incertidumbre sobre si recibiremos o no contenido relevante –un mensaje, un post en nuestro muro de Facebook, un Like en la última foto que hemos subido a Instagram, etcétera–. Es decir, el premio –o gratificación– no está asegurado, y ese factor de aleatoriedad, en tanto en cuanto suceda al menos en un 25% de las ocasiones, es más efectivo, a la hora de hacernos volver repetidamente a la tecnología, que si el premio fuese consistente.

En una interesante charla TED, Tom Chatfield, diseñador de videojuegos, explica cómo, después de analizar datos sobre millones de jugadores, los diseñadores de videojuegos descubrieron que la manera más efectiva de mantener a las personas ante la pantalla es concederles un premio –por ejemplo, pasar un nivel, recolectar monedas, etcétera– al menos el 25% de las veces que intentan conseguirlo.

Otro ejemplo de la efectividad de estas gratificaciones aleatorias son las máquinas de jugar en los casinos. Estudios con animales muestran que los premios aleatorios no solo motivan a los animales a realizar una cierta tarea, sino también a hacerla mejor que si reciben premios consistentemente cada vez que la hacen bien.

Por un lado, la tecnología nos hace enfocarnos en el presente y en las gratificaciones inmediatas; por otro, los estudios corroboran el valor y la importancia de la habilidad para aceptar gratificaciones a largo plazo. Es importante ser conscientes de esta tensión, y fomentar actividades que refuercen la gratificación a largo plazo en todos nosotros, pero sobre todo en niños y adolescentes.

El mito de la multitarea

La atención humana es un bien escaso. En ese principio se basa el concepto de la economía de la atención, acuñado por Herbert Simon en 1971 y de nuevo de actualidad, teniendo en cuenta la capacidad de las nuevas tecnologías para confinar nuestra atención en el ahora.

Según los analistas Thomas Davenport y John Beck, autores del libro La economía de la atención, publicado en 2001, la atención humana “es un estado mental de concentración en un elemento en particular”. Una vez percibimos un objeto o contenido concreto le prestamos atención y, en función de lo percibido, decidimos cómo actuar. Conforme tenemos acceso a más contenidos y aplicaciones, la atención humana se convierte en el factor limitante en el consumo de información.

Además, esta lucha constante por reclamar nuestra atención nos hace caer en un estado de multitarea permanente, en el que nos dedicamos superficialmente a varias cosas a la vez, con cambios muy rápidos de atención de una cosa a otra. De hecho, casi nos parece imposible hoy en día hacer una única cosa, sobre todo en el contexto tecnológico: vemos la televisión con el móvil en la mano, manteniendo varias conversaciones de texto a la vez o mirando contenidos en internet. La tecnología nos hace sentir como superhéroes, capaces de hacer varias cosas a la vez.

Pero ¿lo somos realmente? Numerosos estudios recientes han investigado el efecto de este estado constante de prestar atención a varios estímulos simultáneos. Y los resultados no son alentadores.

Un estudio de la Universidad de California en Irvine (EE. UU.) con trabajadores en una oficina analizó el impacto de las interrupciones, y encontró que se tardaba al menos 25 minutos en recuperar el grado de productividad previo a la llamada, el email o la notificación correspondiente. Otro estudio llevado a cabo por el Instituto de Psiquiatría de la Universidad de Londres observó que las personas distraídas por la tecnología experimentaban una disminución de su coeficiente intelectual superior al que tendrían si hubiesen consumido marihuana.

Todos estos trabajos apuntan a que la aparente capacidad de hacer varias cosas a la vez, apoyada por la tecnología, es una ilusión: el cerebro procesa la información de manera lineal. Además, el estado de multitarea casi permanente podría tener un impacto negativo en nuestra capacidad para enfocarnos en una única tarea durante largos periodos de tiempo, así como para el control emocional.

Vivimos rodeados de tecnología que compite por atrapar nuestra atención. Todos estos estímulos son muy atractivos para nuestro cerebro y por ello a menudo nos resulta difícil resistirnos. Sin embargo, es fundamental fomentar y cultivar la habilidad de concentrarse y sostener la atención en una única tarea, para conseguir una generación de erudit@s digitales.

No obstante, no siempre encontramos estímulos lo bastante interesantes como para capturar nuestra atención. Y es entonces cuando sentimos aburrimiento. ¿Qué relación tiene la tecnología con el aburrimiento? ¿Cuándo fue la última vez que estuvimos aburridos? Con un teléfono siempre en nuestras manos, conectado y cargado de opciones para el entretenimiento y la comunicación, ¿estamos perdiendo la habilidad de estar aburridos? ¿Qué consecuencias puede tener esta pérdida del aburrimiento en nuestras vidas? Exploremos estas preguntas en la siguiente sección.

El valor del aburrimiento

El aburrimiento es un estado emocional caracterizado por la falta de estímulos y por el deseo de satisfacer esta carencia. Una persona aburrida siente a menudo desinterés por los estímulos a su alcance, y puede resultarle difícil concentrarse en la actividad del momento. El psicólogo de la Universidad de York (Toronto, Canadá) John D. Eastwood enfatiza que una persona aburrida no es simplemente alguien sin nada que hacer, sino alguien que busca activamente estimulación sin encontrarla 15. De hecho, el ansia de escapar

al aburrimiento puede llegar a ser muy intensa: en un estudio liderado por Timothy Wilson, de la Universidad de Virginia (EE. UU.), los participantes prefirieron administrarse dolorosos electroshocks antes que estar solos sin hacer nada durante unos minutos 16.

Pero el aburrimiento no tiene por qué ser necesariamente negativo. Como dijo Dorothy Parker, poeta y escritora americana, “la cura contra el aburrimiento es la curiosidad”. Andreas Elpidorou, de la Universidad de Louisville (EE. UU.), escribe en un artículo científico que “sin el aburrimiento, estaríamos atrapados en situaciones poco gratificantes y perderíamos la oportunidad de vivir experiencias emocional, cognitiva y socialmente estimulantes. El aburrimiento nos indica que no estamos haciendo algo que nos satisface y nos empuja a cambiar de actividad, buscando una actividad más estimulante” 17.

Otros beneficios del aburrimiento incluyen la oportunidad de iniciar procesos creativos y de autorreflexión 18. Son varios los estudios que hallan conexiones entre el aburrimiento y la creatividad. Si perdemos la capacidad de estar aburridos, de frenar el procesado continuo de estímulos y de dejar que nuestra mente genere ideas, quizás también estaremos perdiendo la creatividad, una de las capacidades que nos identifican como humanos.

Por ello, el tercer elemento que considero importante en una cultura de erudit@s digitales es el aburrimiento.

Al proporcionarnos estimulación constante la tecnología cambia nuestra tolerancia al aburrimiento: con el tiempo nos habituamos a un cierto nivel de exposición a estímulos, y cuando ésta disminuye nos sentimos aburridos 19.

Un estudio del Centro Internacional para los Medios y la Agenda Pública (ICMPA) solicitó a un millar de estudiantes de diez países en cinco continentes que pasaran 24 horas sin ningún acceso a contenidos multimedia, a medios de comunicación ni al móvil –redes sociales, WhatsApp, etcétera–20. Una vez concluido el periodo de abstinencia digital los estudiantes compartieron sus experiencias por escrito. Sus más de medio millón de palabras revelaron tendencias y elementos comunes en su experiencia.

Así, los estudiantes utilizaron reiteradamente el término adicción para describir su relación con las tecnologías de comunicación (“me moría de ganas por usar un teléfono, me sentía como un drogadicto sin droga”). Además, en todos los países una mayoría de estudiantes reconocieron haber fracasado en su intento por estar desconectados durante 24 horas. También admitieron que sus teléfonos móviles ya forman parte de sus cuerpos, y por ello les resulta imposible no tenerlos cerca –de hecho, existe la nomofobia, el miedo irracional a no tener el móvil cerca o no saber dónde está–.

Enfatizaron que estar conectados no es simplemente un hábito, sino un elemento esencial en su capacidad de relacionarse con los demás. La soledad emergió en sus relatos como el sentimiento que aflora al estar desconectados.

Los estudiantes ganaron tiempo al estar desconectados, pero les resultó difícil imaginar cómo ocupar esas horas. El teléfono fue reconocido como elemento que proporciona seguridad y confort. En cuanto al móvil como herramienta para recibir información, en la mayoría de los casos los jóvenes reconocieron leer solo los titulares –140 caracteres de Twitter– de una noticia. Las noticias completas les parece demasiado largas. La televisión fue considerada un medio para relajarse, mientras que la música emergió como elemento de escape primordial y para influir en el estado de ánimo.

Estos resultados coinciden con los de otros trabajos que ven en los teléfonos móviles una herramienta para pasar el tiempo y combatir el aburrimiento 21. Los móviles se han convertido en nuestros más fieles compañeros; los mantenemos próximos, a nuestro lado, en situaciones de aburrimiento como en los viajes de metro y autobús, en los momentos de espera, etcétera. Recurrimos al teléfono para pasar el tiempo, para autoestimularnos, sin ninguna tarea concreta en mente.

Desde mi punto de vista, esta realidad podría representar una oportunidad: si los móviles fuesen capaces de detectar cuándo estamos aburridos, también podrían sugerir un mejor uso de esos momentos. Podrían recomendarnos contenidos, servicios o actividades relevantes; sugerirnos prestar atención a tareas pendientes; o ayudarnos a hacer un uso positivo de ese momento de aburrimiento, quizás fomentando la introspección y la creatividad. Exploramos estas ideas en un proyecto realizado en mi equipo de investigación en 2015 con resultados muy prometedores 22 23. ¿Por qué no diseñamos tecnología que nos sugiera que la apaguemos?

UNA ‘APP’ PARA ABURRIDOS

El aburrimiento podría abrir una inesperada ventana de oportunidad para desconectarnos de la tecnología. Junto con mi grupo de investigación desarrollamos en 2015 una aplicación para el móvil, Borapp 23, capaz de determinar si el usuario del teléfono está aburrido o no. El sistema está lejos de ser perfecto, pero representa un primer paso en el diseño de tecnología que nos entiende mejor y tiene el potencial de ayudarnos en la gestión de nuestro tiempo y nuestras emociones.

Borapp podría ser una herramienta que nos ayudase a recuperar un estado emocional que estamos empezando a perder, el aburrimiento, y a aprovechar sus aspectos positivos. Aunque un gran porcentaje de nosotros –y aún mayor de adolescentes– no podamos vivir sin nuestros móviles y estemos constantemente conectados, ¿tiene valor el tiempo que pasamos desconectados? ¿Qué pasaría si nuestro móvil nos sugiriese que lo apagásemos? ¿O será el aburrimiento una reliquia del pasado? ¿Qué pasaría con nuestra creatividad en ese caso?

La importancia del tiempo off

Conforme desarrollamos una relación más sinérgica e íntima con la tecnología –una tecnología que a su vez es cada vez más potente, inteligente y conectada–, se convierte en crítico el que seamos capaces de mantener un número mínimo de horas al día de descanso tecnológico, de tiempo off.

Jennifer Falbe, del departamento de Ecología Humana de la Universidad de California, abordó en un estudio publicado en 2015 la relación entre uso de pantallas y sueño24, en más de 2.000 niños y niñas de cuarto y primero de la ESO en Massachusetts, EE. UU. Los resultados apuntan a la conveniencia de poner restricciones a

la tecnología –tabletas, teléfonos, televisión– en los dormitorios de los niños y adolescentes. Los que dormían cerca de una pantalla pequeña declararon dormir 20 minutos menos al día que los que no tenían pantallas; y en el grupo con pantallas también eran más los que sentían no haber dormido o descansado lo bastante.

Las actividades que se realizan con estos dispositivos suelen ser muy estimulantes, lo que dificulta la conciliación de un sueño que, por añadidura, puede verse interrumpido por notificaciones audibles durante la noche. Además, la luz de las pantallas brillantes envía al cuerpo la señal de que todavía es de día, lo que inhibe la producción de una hormona implicada en la regulación del sueño, la melatonina. Por ello se recomienda tener unos minutos de descanso con la luz apagada antes de ir a dormir.

Más allá de la necesidad de tener suficientes horas de descanso de calidad, varios estudios corroboran la importancia de saber desconectar y realizar actividades no tecnológicas.

Una actividad que es importante mantener son las relaciones humanas cara a cara, sin tecnología. A fin de cuentas, el Homo sapiens es una especie social. La profesora del MIT Sherry Turkle lleva más de treinta años investigando la relación subjetiva entre las personas y la tecnología. En su libro, “En Defensa de la conversación” 25, analiza el impacto que está teniendo la tecnología en nuestra capacidad para

conversar cara a cara, y postula que la disminución –incluso en algunos casos desaparición– de las conversaciones en nuestras vidas representa una grave amenaza para nuestras relaciones, nuestra creatividad y también nuestra productividad.

Mantener un equilibrio entre la comunicación cara y cara y la comunicación mediada por la tecnología va a ser crítico, sobre todo la tecnología que utilizamos para mantenernos conectados tenga las limitaciones actuales, forzándonos en muchos casos a comunicarnos usando únicamente texto y por tanto perdiendo la riqueza de lenguaje no verbal que caracteriza la comunicación humana.

También será necesario equilibrar nuestras interacciones con sistemas conversacionales inteligentes –asistentes personales como Alexa o Google Home– y nuestras interacciones con humanos. Estos sistemas carecen hoy en día de habilidades de las inteligencias social y emocional, y en muchos casos son incapaces de interpretar correctamente el lenguaje no verbal, tan importante y característico de la comunicación humana. Y ya sabemos que, en la naturaleza, lo que no se usa, se pierde…

Más allá de la comunicación y las relaciones, mantener una presencia y conexión físicas con el mundo que nos rodea es fundamental para nuestra salud mental, nuestro bienestar emocional, nuestra creatividad y, en último grado, nuestra felicidad.

Referencias

-

D. Lazer, M. Baum, Y. Benkler, A. J. Berinsky, K. Greenhill, F. Menczer y e. al, «The science of fake news», Science, pp. 1094-1096, 2018. ↩

-

Purdy, Mark y Daugherty, Paul. Accenture (2017). «How AI Boosts Industry Profits And Innovation». [https://www.accenture.com/fr-fr/_acnmedia/36dc7f76eab444cab6a7f44017cc3997.pdf] ↩

-

S. Ahmad y J. Hawkins, «Properties of Sparse Distributed Representations and their Application to Hierarchical Temporary Memory,» Arxiv, 2015. ↩

-

Human Age Institute. «Posiciones y competencias más demandadas. Informe EPyCE 2018». [https://humanageinstitute.org/wp-content/uploads/2019/03/Informe-EPYCE-2018.pdf] ↩

-

World Economic Forum. (2018). «The Future of Jobs Report 2018». [http://www3.weforum.org/docs/WEF_Future_of_Jobs_2018.pdf] ↩

-

Kiss, M., & Parlamento Europeo. Dirección General de Servicios de Estudios Parlamentarios. (2016). «Digital skills in the EU labour market [er]: In-depth analysis». [http://dx.publications.] [europa.eu/10.2861/451320] ↩

-

Y. N. Harari, «21 lessons for the 21st century», London: Penguin Random House, UK, 2018. ↩

-

S. Lluna y J. Pedreira, «Los nativos digitales no existen», Deusto Editorial, 2017. ↩

-

https://icono.fecyt.es/principales-indicadores/interes-por-la-ciencia ↩

-

S. Bocconi, S. Chioccariello, G. Dettori, A. Ferrari y K. Engelhardt, «Developing computational thinking in compulsory education», JCR Science for Policy Report, 2016. ↩

-

Wing, J. M. (2006, marzo). «Computational Thinking». COMMUNICATIONS OF THE ACM, 49 No 3. [https://www.cs.cmu.edu/~15110-s13/Wing06-ct.pdf] ↩

-

E. Kross, W. Mischel y Y. Shoda, «Enabling self-control», Social Psychological Foundations of Clinical Psychology, nº June, pp. 375-394, 2011. ↩

-

Activate. (2018). «Activate Tech & Media Outlook 2019». [https://www.slideshare.net/ActivateInc/activate-tech-mediaoutlook-2019] ↩

-

T. Goetz, N. Hall, A. Frenzel y U. Nett «Types of boredom: An experience sampling approach», Motivation and Emotion, vol. 38, nº 3, pp. 401-19, 2014. ↩

-

T. Wilson, D. Reinhard, E. Westgate, D. Gilbert, N. Ellerbeck, C. Hahn, C. Brown y A. Shaked, «Just think: The challenges of the disengaged mind», Science, vol. 345, pp. 75-77, 2014. ↩

-

https://ec.europa.eu/info/sites/info/files/commission-white-paper-artificialintelligence-feb2020_en.pdf ↩

-

S. J. Vodanovich, «On the possible benefits of boredom: A neglected area in personality research», Psychology and Education: An Interdisciplinary Journal, 2003. ↩

-

J. Eastwood, A. Frischen y M. Fenske, «The unengaged mind: Defining boredom in terms of attention», Perspectives on Psychological Science, vol. 7, nº 5, pp. 482-95, 2012. ↩

-

B. Brown, M. McCregor y D. McMillan, «100 days of iPhone use: Understanding the details of mobile device use», Proceedings of the ACM MobileHCI, 2014. ↩

-

A. Matic, M. Pielot y N. Oliver, «Boredom-Computer Interaction: Boredom Proneness and SmartPhone Use», Proceedings of the ACM Int Conf on Ubiquitous Computing (Ubicomp), 2015. ↩

-

M. Pielot, T. Dingler, J. San Pedro y N. Oliver, «When Attention is not Scarce: Detecting Boredom from Mobile Phone Usage», Proceedings of the ACM Int Conf on Ubiquitous Computing (Ubicomp), 2015. ↩ ↩2

-

Falbe J, Davison KK, Franckle RL, Gehre C, Gortmaker SL, Smith L, Land T, Taveras EM. Screens in children’s sleep environments, sleep duration, and perceived insufficient rest. Pediatrics. 2015; 135(2):e367-75. ↩

-

S. Turkle, «En defensa de la conversación», Ed. Atico de los libros, ISBN-10 8416222274, 2015. ↩